前端学习合理的知识结构

前端技术排名网站:https://risingstars.js.org/2022/zh

前端工程师的困惑与挑战

工作期间我发现,前端工程师自身容易形成一些误解,常见的有两个:

工作年限 = 级别(能力)

框架/工具使用得越多越好

持有第一种误解的前端工程师认为,只要在前端这个领域工作的年限久了,就自然而然成为了高级工程师。具体表现是被动工作、被动学习,沉浸在自己的舒适区,直到工作数年后突然发现日子不好混了,自身学习能力又不够,遭遇所谓的中年危机。 要避免工作年限成为劣势,我的建议是每年定期回顾自己所做的工作,以此来判断你是在舒适圈内做熟悉、重复的事情,还是在不断地挑战提升自己。

第二种误解比较可怕,一般持有这种误解的工程师表现为使用过多种技术,但都只停留在表面,会调用 API 而已,杂而不精。一方面这种工程师所掌握的知识太浅,任何一个初级工程师,给予一定的时间和练习机会都能达到他的水平;另一方面也暴露了他没有深入学习的能力和精神,而这也是成为高级工程师的重要阻力。 时间对于软件工程师来说是一把双刃剑,如果利用好时间进行有效的知识积累,那么时间会是朋友,否则时间终将成为敌人。

举个例子,下面是某人的工作经验简述:

使用 zepto.js 和 CSS3 动效开发过一些移动端活动页面;

使用 React 和 Ant Design 开发过一个医药商城 Web App 的核心模块及后台管理页面;

熟悉 Git 工具和代码管理流程;

熟悉 webpack、Gulp.js 等工具的使用;

自学了 Node.js、Docker、MongoDB,能编写一些小项目。

如果他是工作 1 年的工程师,那么会让面试官有些小惊喜;如果工作了 3 年,应该也还算不错。但如果已经工作 5 年了,面试官可能要好好考察他一下了。

因为对于工作 5 年的工程师,面试官最看重的是工作能力,而这里面并没有很好地体现出来。虽然简历中表明他使用过主流框架和工具开发过项目,但从描述上看,项目本身并不复杂,且看不出其熟练程度。(这里值得一提的是,“熟练”这种主观性的自我描述建议少用,很容易适得其反,技艺越是精深的工程师对“熟练”、“精通”这种描述越谨慎,因为他们知道的越多,发现未知的也更多,同样也知道“人外有人”的道理。)

另外,前端工程师之间的能力和薪资存在着“贫富分化”的现象,而且随着时间的推进在不断加剧。

这也很好理解,薪资越高的工程师往往学习能力越强,从事着公司的重要岗位和工作,其成长速度也越快;而薪资低的工程师则往往学习能力有限,从事着低价值、重复性高的工作,也更容易困于瓶颈难以突破。

综合来看,前端工程师在职业发展和技能提升上,主要是被下面三个问题所困扰。

1.前端知识点太多

- 相对于其他开发岗位而言,前端需要掌握三门语言。 最简单的 HTML 语言有上百个用法各异的标签,每个标签还有属性,还有 DOM 提供的 API;CSS 的知识点也不少,选择器有十几类,属性有上百种,常用的枚举属性 display 都有十几种值;至于 JavaScript 的知识点,看看六七百页的犀牛书就可见一斑了。

2.前端技术更新速度快

- 前端框架有好几种,主流就有 2~3 种,这还不算每个框架的版本;

- 构建工具不断更新,有些框架还封装了自己的命令行工具;

- 不断出现新技术名词,如 SSR、PWA、Serverless、Flutter 等;

- ......

面对前端技术浪潮,有人开始抱怨“别更新了”、“学不动了”……当然,消极抱怨并不能阻止技术的进步,同时对自己的技能提升也起不到任何帮助,不应效仿。但过于积极学习的人,也并不十分可取。

记得有一次参加线下技术分享会,有工程师发言说自己要在两年内成为前端架构师,然后还说出了自己的计划,就是把各种所知的前端技术名词像报菜名一样说了一遍,随后再补充一句“看懂其源码”。

抱着类似想法的初级/中级工程师其实并不少见,以为拿到了一份技能图谱,或者背一背面试题就能一跃成为高级/资深前端工程师。

这种企图通过量变引起质变的方式并不可取,时间精力是一方面,更重要的是,囫囵吞枣的学习方式缺乏对前端知识系统的认知,只是把知识点堆砌在一起而没有形成自己的认知框架。就像沙子、钢筋、水泥堆在一起顶多只是原材料,只有经过建筑师之手,它们才能成为高楼大厦。

- 3.前端应用场景越来越复杂

- 当 Node.js 出现的时候,前端工程师已经可以涉足后端了,甚至独立开发整个 B/S 架构的系统;而当混合应用、小程序等技术出现时,则意味着前端工程师可以开发多个终端系统。

- 不同开发场景下的实现目标、API 及调试工具又各有差异,比如微信小程序和钉钉小程序就提供了各自独立的开发工具,浏览器环境下为 JavaScript 提供了 BOM 和 DOM,而 Node.js 环境下提供的是 fs、net 等模块。

如何破局

建立合理的知识结构

- 合理的知识结构既指知识框架的可扩展性,同时也指每个知识点的完备性。

- 知识框架的可扩展性是指,在尽量少的调整自身已有知识结构的情况下,就可以不断将新的技术知识吸纳进来。就像架构师搭建的项目框架一样,能帮助开发工程师方便快速地完成新功能的开发。而差的知识框架就如糟糕的项目,会随着功能增加而变得复杂臃肿,最终不得不将代码推翻重构。

- 知识点的完备性是指,每个知识点不应停留在只会调用接口函数的程度,而是深入其实现原理,然后能加以运用,从而构建更复杂更具通用性的项目。

培养可复用的工作能力

- 除了最基本的能看懂文档、调用接口的编程能力之外,还着重帮助你提升以下 3 方面的能力:

- 探究能力,深度探究技术背后的原理,并且能结合实践灵活运用;

- 解构能力,能够分析和分解复杂问题,并一步步解决;

- 归纳能力,建立知识点之间的联系,并找到其共性,从而达到举一反三的目的。

- 除了最基本的能看懂文档、调用接口的编程能力之外,还着重帮助你提升以下 3 方面的能力:

不管你是大厂螺丝钉,还是小厂顶梁柱,这些能力都将帮助你在晋升的道路上快步前行。

模块分类

- 模块一,前端核心基础知识:带你深入理解前端工程师的必备技能 HTML、CSS、JavaScript 及网络协议,掌握它们的高级用法,比如 DOM 事件应用、CSS 管理、JavaScript 异步处理方案,以及 API 设计。同时深入浏览器内核的工作机制,让你成为一个懂页面样式,更懂浏览器的前端工程师。

- 模块二,实际应用场景解析:解析热门前端框架,理解其设计原理,让你不再只停留会用框架的程度。深入分析前端工程化中的重要工具 webpack,建立工程化、工具化思维,带你向高级前端工程师迈进。

- 模块三,综合能力提升:前端知识扩展部分,通过理解 Node.js 核心原理与应用场景,扩大你的开发能力边界,不再只局限于浏览器,同时通过算法与数据结构的学习,建立解决复杂问题的能力,助你构筑一条既深又宽的“护城河”。

- 模块四,彩蛋:谈谈工作之内、技术之外的内容,包括职业规划和面试技巧,帮你直取高薪 Offer。

前端核心基础知识

你真的熟悉 HTML 标签吗?

主要讲解那些“看不见”的 HTML 标签及其使用场景。

提到 HTML 标签,前端工程师会非常熟悉,因为在开发页面时经常使用。但往往关注更多的是页面渲染效果及交互逻辑,也就是对用户可见可操作的部分,比如表单、菜单栏、列表、图文。

其实还有一些非常重要却容易被忽视的标签,这些标签大多数用在页面头部 head 标签内,虽然对用户不可见,但如果在某些场景下,比如交互实现、性能优化、搜索优化,合理利用它们就可以达到事半功倍的效果。

交互实现

编码原则:Less code, less bug。

在实现一个功能的时候,我们编写的代码越多,不仅开发成本越高,而且代码的健壮性也越差。

它和 KISS(Keep it simple, stupid)原则及奥卡姆剃刀原则(如无必要,勿增实体)有相同的意思,都是提倡编码简约。

下面介绍几个标签,来看看如何帮助我们更简单地实现一些页面交互效果。

meta 标签:自动刷新/跳转

假设要实现一个类似 PPT 自动播放的效果,你很可能会想到使用 JavaScript 定时器控制页面跳转来实现。但其实有更加简洁的实现方法,比如通过 meta 标签来实现:

<meta http-equiv="Refresh" content="5; URL=page2.html" />上面的代码会在 5s 之后自动跳转到同域下的 page2.html 页面。我们要实现 PPT 自动播放的功能,只需要在每个页面的 meta 标签内设置好下一个页面的地址即可。

另一种场景,比如 “每隔一分钟就需要刷新页面的大屏幕监控” ,也可以通过 meta 标签来实现,只需去掉后面的 URL 即可

<meta http-equiv="Refresh" content="60" />细心的你可能会好奇,既然这样做又方便又快捷,为什么这种用法比较少见呢?

一方面是因为不少前端工程师对 meta 标签用法缺乏深入了解,另一方面也是因为在使用它的时候,刷新和跳转操作是不可取消的,所以对刷新时间间隔或者需要手动取消的,还是推荐使用 JavaScript 定时器来实现。

但是,如果你只是想实现页面的定时刷新或跳转(比如某些页面缺乏访问权限,在 x 秒后跳回首页这样的场景)建议你可以实践下 meta 标签的用法。

title 标签与 Hack 手段:消息提醒

作为前端工程师的你对 B/S 架构肯定不陌生,它有很多的优点,比如版本更新方便、跨平台、跨终端,但在处理某些场景,比如即时通信场景时,就会变得比较麻烦。

因为前后端通信深度依赖 HTTP 协议,而 HTTP 协议采用“请求-响应”模式,这就决定了服务端也只能被动地发送数据。一种低效的解决方案是客户端通过轮询机制获取最新消息(HTML5 下可使用 WebSocket 协议)。

消息提醒功能实现则比较困难,HTML5 标准发布之前,浏览器没有开放图标闪烁、弹出系统消息之类的接口,只能借助一些 Hack 的手段,比如修改 title 标签来达到类似的效果(HTML5 下可使用 Web Notifications API 弹出系统消息)。

下面这段代码中,通过定时修改 title 标签内容,模拟了类似消息提醒的闪烁效果:

let msgNum = 1; // 消息条数

let cnt = 0; // 计数器

const inerval = setInterval(() => {

cnt = (cnt + 1) % 2;

if (msgNum === 0) {

// 通过DOM修改title

document.title += `聊天页面`;

clearInterval(interval);

return;

}

const prefix = cnt % 2 ? `新消息(${msgNum})` : "";

document.title = `${prefix}聊天页面`;

}, 1000);实现效果如下图所示,可以看到标签名称上有提示文字在闪烁。

通过模拟消息闪烁,可以让用户在浏览其他页面的时候,及时得知服务端返回的消息。

定时修改 title 标签内容,除了用来实现闪烁效果之外,还可以制作其他动画效果,比如文字滚动,但需要注意浏览器会对 title 标签文本进行去空格操作。

动态修改 title 标签的用途不仅在于消息提醒,你还可以将一些关键信息显示到标签上(比如下载时的进度、当前操作步骤),从而提升用户体验。

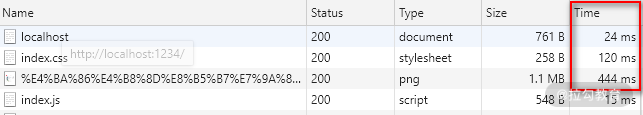

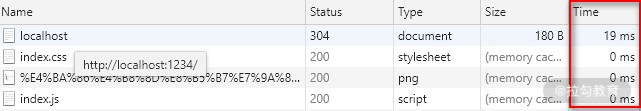

性能优化

性能优化是前端开发中避不开的问题,性能问题无外乎两方面原因:渲染速度慢、请求时间长。性能优化虽然涉及很多复杂的原因和解决方案,但其实只要通过合理地使用标签,就可以在一定程度上提升渲染速度以及减少请求时间。

script 标签:调整加载顺序提升渲染速度

由于浏览器的底层运行机制,渲染引擎在解析 HTML 时,若遇到 script 标签引用文件,则会暂停解析过程,同时通知网络线程加载文件,文件加载后会切换至 JavaScript 引擎来执行对应代码,代码执行完成之后切换至渲染引擎继续渲染页面。

在这一过程中可以看到,页面渲染过程中包含了请求文件以及执行文件的时间,但页面的首次渲染可能并不依赖这些文件,这些请求和执行文件的动作反而延长了用户看到页面的时间,从而降低了用户体验。

为了减少这些时间损耗,可以借助 script 标签的 3 个属性来实现。

- async 属性。立即请求文件,但不阻塞渲染引擎,而是文件加载完毕后阻塞渲染引擎并立即执行文件内容。

- defer 属性。立即请求文件,但不阻塞渲染引擎,等到解析完 HTML 之后再执行文件内容。

- HTML5 标准 type 属性,对应值为“module”。让浏览器按照 ECMA Script 6 标准将文件当作模块进行解析,默认阻塞效果同 defer,也可以配合 async 在请求完成后立即执行。

<script></script>

<script defer></script>

<script async></script>

<script type="module"></script>

<script type="module” async></script>采用 3 种属性都能减少请求文件引起的阻塞时间,只有 defer 属性以及 type="module" 情况下能保证渲染引擎的优先执行,从而减少执行文件内容消耗的时间,让用户更快地看见页面(即使这些页面内容可能并没有完全地显示)。

除此之外还应当注意,当渲染引擎解析 HTML 遇到 script 标签引入文件时,会立即进行一次渲染。

所以这也就是为什么构建工具会把编译好的引用 JavaScript 代码的 script 标签放入到 body 标签底部,因为当渲染引擎执行到 body 底部时会先将已解析的内容渲染出来,然后再去请求相应的 JavaScript 文件。

如果是内联脚本(即不通过 src 属性引用外部脚本文件直接在 HTML 编写 JavaScript 代码的形式),渲染引擎则不会渲染。

link 标签:通过预处理提升渲染速度

在我们对大型单页应用进行性能优化时,也许会用到按需懒加载的方式,来加载对应的模块,但如果能合理利用 link 标签的 rel 属性值来进行预加载,就能进一步提升渲染速度。

dns-prefetch。当 link 标签的 rel 属性值为“dns-prefetch”时,浏览器会对某个域名预先进行 DNS 解析并缓存。这样,当浏览器在请求同域名资源的时候,能省去从域名查询 IP 的过程,从而减少时间损耗。下图是淘宝网设置的 DNS 预解析。

- html

<link rel="dns-prefetch" href="//g.alicdn.com" />

preconnect。让浏览器在一个 HTTP 请求正式发给服务器前预先执行一些操作,这包括 DNS 解析、TLS 协商、TCP 握手,通过消除往返延迟来为用户节省时间。

prefetch/preload。两个值都是让浏览器预先下载并缓存某个资源,但不同的是,prefetch 可能会在浏览器忙时被忽略,而 preload 则是一定会被预先下载。

prerender。浏览器不仅会加载资源,还会解析执行页面,进行预渲染。

这几个属性值恰好反映了浏览器获取资源文件的过程

流程简图:浏览器获取资源文件的流程

搜索优化

你所写的前端代码,除了要让浏览器更好执行,有时候也要考虑更方便其他程序(如搜索引擎)理解。合理地使用 meta 标签和 link 标签,恰好能让搜索引擎更好地理解和收录我们的页面。

meta 标签:提取关键信息

通过 meta 标签可以设置页面的描述信息,从而让搜索引擎更好地展示搜索结果。

例如,在百度中搜索“拉勾”,就会发现网站的描述信息,这些描述信息就是通过 meta 标签专门为搜索引擎设置的,目的是方便用户预览搜索到的结果。

自行百度

为了让搜索引擎更好地识别页面,除了描述信息之外还可以使用关键字,这样即使页面其他地方没有包含搜索内容,也可以被搜索到(当然搜索引擎有自己的权重和算法,如果滥用关键字是会被降权的,比如 Google 引擎就会对堆砌大量相同关键词的网页进行惩罚,降低它被搜索到的权重)。

当我们搜索关键字“垂直互联网招聘”的时候搜索结果会显示拉勾网的信息,虽然显示的搜索内容上并没有看到“垂直互联网招聘”字样,这就是因为拉勾网页面中设置了这个关键字。

对应代码如下:

<meta

content="拉勾,拉勾网,拉勾招聘,拉钩, 拉钩网 ,互联网招聘,拉勾互联网招聘, 移动互联网招聘, 垂直互联网招聘, 微信招聘, 微博招聘, 拉勾官网, 拉勾百科,跳槽, 高薪职位, 互联网圈子, IT招聘, 职场招聘, 猎头招聘,O2O招聘, LBS招聘, 社交招聘, 校园招聘, 校招,社会招聘,社招"

name="keywords"

/>在实际工作中,推荐使用一些关键字工具来挑选,比如 Google Trends、站长工具。

link 标签:减少重复

有时候为了用户访问方便或者出于历史原因,对于同一个页面会有多个网址,又或者存在某些重定向页面,比如:

那么在这些页面中可以这样设置:

<link href="https://lagou.com/a.html" rel="canonical" />这样可以让搜索引擎避免花费时间抓取重复网页。不过需要注意的是,它还有个限制条件,那就是指向的网站不允许跨域。

当然,要合并网址还有其他的方式,比如使用站点地图,或者在 HTTP 请求响应头部添加 rel="canonical"。这里,就不展开介绍了,道理都是相通的,多探索和实践。

延伸内容:OGP(开放图表协议)

延伸说一说基于 meta 标签扩展属性值实现的第三方协议——OGP(Open Graph Protocal,开放图表协议 )。

OGP 是 Facebook 公司在 2010 年提出的,目的是通过增加文档信息来提升社交网页在被分享时的预览效果。

你只需要在一些分享页面中添加一些 meta 标签及属性,支持 OGP 协议的社交网站就会在解析页面时生成丰富的预览信息,比如站点名称、网页作者、预览图片。具体预览效果会因各个网站而有所变化。

下面是微信文章支持 OGP 协议的代码,可以看到通过 meta 标签属性值声明了:网址、预览图片、描述信息、站点名称、网页类型和作者信息。

<meta property="og:title" content="标题" />

<meta property="og:url" content="url链接" />

<meta property="og:image" content="图片链接" />

<meta property="og:description" content="简单说明" />

<meta property="og:site_name" content="平台名字" />

<meta property="og:type" content="类型:arcticle|文章" />

<meta property="og:arcticle:author" content="作者" />

<meta property="twitter:card" content="卡片" />

<meta property="twitter:image" content="图片链接" />

<meta property="twitter:title" content="标题" />

<meta property="twitter:creator" content="创建者" />

<meta property="twitter:site" content="站点平台名字" />

<meta property="twitter:description" content="说明" />

<meta property="twitter:" content="" />现在百度已经宣布支持,微信文章的不少页面上也添加了相关标签属性,有兴趣的话你可以查看官方网站:https://ogp.me/

HTML 少见的标签总结

本课时,我从交互实现、性能优化、搜索优化场景出发,分别讲解了 meta 标签、title 标签、link 标签,以及 script 标签在这些场景中的重要作用,希望这些内容你都能有效地应用到工作场景中,不再只是了解,而是能够熟练运用。

如何高效的操作 DOM 元素

什么是 DOM

DOM(Document Object Model,文档对象模型)是 JavaScript 操作 HTML 的接口(这里只讨论属于前端范畴的 HTML DOM),属于前端的入门知识,同样也是核心内容,因为大部分前端功能都需要借助 DOM 来实现,比如:

动态渲染列表、表格表单数据;

监听点击、提交事件;

懒加载一些脚本或样式文件;

实现动态展开树组件,表单组件级联等这类复杂的操作。

如果你查看过 DOM V3 标准,会发现包含多个内容,但归纳起来常用的主要由 3 个部分组成:

DOM 节点

DOM 事件

选择区域

选择区域的使用场景有限,一般用于富文本编辑类业务,我们不做深入讨论;DOM 事件有一定的关联性,将在下一课时中详细讨论;对于 DOM 节点,需与另外两个概念标签和元素进行区分:

标签是 HTML 的基本单位,比如 p、div、input;

节点是 DOM 树的基本单位,有多种类型,比如注释节点、文本节点;

元素是节点中的一种,与 HTML 标签相对应,比如 p 标签会对应 p 元素。

举例说明,在下面的代码中,“p” 是标签, 生成 DOM 树的时候会产生两个节点,一个是元素节点 p,另一个是字符串为“hhhhh”的文本节点。

<p>hhhhh</p>会框架更要会 DOM

有的前端工程师因为平常使用 Vue、React 这些框架比较多,觉得直接操作 DOM 的情况比较少,认为熟悉框架就行,不需要详细了解 DOM。这个观点对于初级工程师而言确实如此,能用框架写页面就算合格。

但对于屏幕前想成为高级/资深前端工程师的你而言,只会使用某个框架或者能答出 DOM 相关面试题,这些肯定是不够的。恰恰相反,作为高级/资深前端工程师,不仅应该对 DOM 有深入的理解,还应该能够借此开发框架插件、修改框架甚至能写出自己的框架。

因此,这一课时我们就深入了解 DOM,谈谈如何高效地操作 DOM。

为什么说 DOM 操作耗时

要解释 DOM 操作带来的性能问题,我们不得不提一下浏览器的工作机制。

线程切换

如果你对浏览器结构有一定了解,就会知道浏览器包含渲染引擎(也称浏览器内核)和 JavaScript 引擎,它们都是单线程运行。单线程的优势是开发方便,避免多线程下的死锁、竞争等问题,劣势是失去了并发能力。

浏览器为了避免两个引擎同时修改页面而造成渲染结果不一致的情况,增加了另外一个机制,这两个引擎具有互斥性,也就是说在某个时刻只有一个引擎在运行,另一个引擎会被阻塞。操作系统在进行线程切换的时候需要保存上一个线程执行时的状态信息并读取下一个线程的状态信息,俗称上下文切换。而这个操作相对而言是比较耗时的。

每次 DOM 操作就会引发线程的上下文切换——从 JavaScript 引擎切换到渲染引擎执行对应操作,然后再切换回 JavaScript 引擎继续执行,这就带来了性能损耗。单次切换消耗的时间是非常少的,但是如果频繁地大量切换,那么就会产生性能问题。

比如下面的测试代码,循环读取一百万次 DOM 中的 body 元素的耗时是读取 JSON 对象耗时的 10 倍。

// 测试次数:一百万次

const times = 1000000

// 缓存body元素

console.time('object')

let body = document.body

// 循环赋值对象作为对照参考

for(let i=0;i<times;i++) {

let tmp = body

}

console.timeEnd('object')// object: 1.77197265625ms

console.time('dom')

// 循环读取body元素引发线程切换

for(let i= 0; <times; i++) {

let tmp = document.body

}

console.timeEnd('dom') // dom: 18.302001953125ms虽然这个例子比较极端,循环次数有些夸张,但如果在循环中包含一些复杂的逻辑或者说涉及到多个元素时,就会造成不可忽视的性能损耗。

重新渲染

另一个更加耗时的因素是元素及样式变化引起的再次渲染,在渲染过程中最耗时的两个步骤为重排(Reflow)与重绘(Repaint)。

浏览器在渲染页面时会将 HTML 和 CSS 分别解析成 DOM 树和 CSSOM 树,然后合并进行排布,再绘制成我们可见的页面。如果在操作 DOM 时涉及到元素、样式的修改,就会引起渲染引擎重新计算样式生成 CSSOM 树,同时还有可能触发对元素的重新排布(简称“重排”)和重新绘制(简称“重绘”)。

可能会影响到其他元素排布的操作就会引起重排,继而引发重绘,比如:

修改元素边距、大小

添加、删除元素

改变窗口大小

与之相反的操作则只会引起重绘,比如:

设置背景图片

修改字体颜色

改变 visibility 属性值

如果想了解更多关于重绘和重排的样式属性,可以参看这个网址:https://csstriggers.com/

两段验证代码

我们通过 Chrome 提供的性能分析工具来对渲染耗时进行分析。

第一段代码,通过修改 div 元素的边距来触发重排,渲染耗时(粗略地认为渲染耗时为紫色 Rendering 事件和绿色 Painting 事件耗时之和)3045 毫秒。

const times = 100000;

let html = "";

for (let i = 0; i < times; i++) {

html += `<div>${i}</div>`;

}

document.body.innerHTML += html;

const divs = document.querySelectorAll("div");

Array.prototype.forEach.call(divs, (div, i) => {

div.style.margin = i % 2 ? "10px" : 0;

});第二段代码,修改 div 元素字体颜色来触发重绘,得到渲染耗时 2359 ms。

const times = 100000;

let html = "";

for (let i = 0; i < times; i++) {

html += `<div>${i}</div>`;

}

document.body.innerHTML += html;

const divs = document.querySelectorAll("div");

Array.prototype.forEach.call(divs, (div, i) => {

div.style.color = i % 2 ? "red" : "green";

});从两段测试代码中可以看出,重排渲染耗时明显高于重绘,同时两者的 Painting 事件耗时接近,也印证了重排会导致重绘。

如何高效操作 DOM

明白了 DOM 操作耗时之处后,要提升性能就变得很简单了,反其道而行之,减少这些操作即可。

在循环外操作元素

比如下面两段测试代码对比了读取 1000 次 JSON 对象以及访问 1000 次 body 元素的耗时差异,相差一个数量级。

const times = 10000;

console.time("switch");

for (let i = 0; i < times; i++) {

document.body === 1 ? console.log(1) : void 0;

}

console.timeEnd("switch"); // 1.873046875ms

var body = JSON.stringify(document.body);

console.time("batch");

for (let i = 0; i < times; i++) {

body === 1 ? console.log(1) : void 0;

}

console.timeEnd("batch"); // 0.846923828125ms当然即使在循环外也要尽量减少操作元素,因为不知道他人调用你的代码时是否处于循环中。

批量操作元素

比如说要创建 1 万个 div 元素,在循环中直接创建再添加到父元素上耗时会非常多。如果采用字符串拼接的形式,先将 1 万个 div 元素的 html 字符串拼接成一个完整字符串,然后赋值给 body 元素的 innerHTML 属性就可以明显减少耗时。

const times = 10000;

console.time("createElement");

for (let i = 0; i < times; i++) {

const div = document.createElement("div");

document.body.appendChild(div);

}

console.timeEnd("createElement"); // 54.964111328125ms

console.time("innerHTML");

let html = "";

for (let i = 0; i < times; i++) {

html += "<div></div>";

}

document.body.innerHTML += html; // 31.919921875ms

console.timeEnd("innerHTML");虽然通过修改 innerHTML 来实现批量操作的方式效率很高,但它并不是万能的。比如要在此基础上实现事件监听就会略微麻烦,只能通过事件代理或者重新选取元素再进行单独绑定。批量操作除了用在创建元素外也可以用于修改元素属性样式,比如下面的例子。

创建 2 万个 div 元素,以单节点树结构进行排布,每个元素有一个对应的序号作为文本内容。现在通过 style 属性对第 1 个 div 元素进行 2 万次样式调整。下面是直接操作 style 属性的代码:

const times = 20000;

let html = "";

for (let i = 0; i < times; i++) {

html = `<div>${i}${html}</div>`;

}

document.body.innerHTML += html;

const div = document.querySelector("div");

for (let i = 0; i < times; i++) {

div.style.fontSize = (i % 12) + 12 + "px";

div.style.color = i % 2 ? "red" : "green";

div.style.margin = (i % 12) + 12 + "px";

}如果将需要修改的样式属性放入 JavaScript 数组,然后对这些修改进行 reduce 操作,得到最终需要的样式之后再设置元素属性,那么性能会提升很多。代码如下:

const times = 20000;

let html = ''

for (let i = 0; i < times; i++) {

html = `<div>${i}${html}</div>`

}

document.body.innerHTML += html

let queue = [] // 创建缓存样式的数组

let microTask // 执行修改样式的微任务

const st = () => {

const div = document.querySelector('div')

// 合并样式

const style = queue.reduce((acc, cur) => ({...acc, ...cur}), {})

for(let prop in style) {

div.style[prop] = style[prop]

}

queue = []

microTask = null

}

const setStyle = (style) => {

queue.push(style)

// 创建微任务

if(!microTask) microTask = Promise.resolve().then(st)

}

for (let i = >0; i < times; i++) {

const style = {

fontSize: (i % 12) + 12 + 'px',

color: i % 2 ? 'red' : 'green',

margin: (i % 12) + 12 + 'px'

}

setStyle(style)

}浏览器性能调试查看,发现紫色的 Rendering 事件耗时有所减少。

virtualDOM 之所以号称高性能,其实现原理就与此类似

缓存元素集合

比如将通过选择器函数获取到的 DOM 元素赋值给变量,之后通过变量操作而不是再次使用选择器函数来获取。 下面举例说明,假设我们现在要将上面代码所创建的 1 万个 div 元素的文本内容进行修改。每次重复使用获取选择器函数来获取元素

for (let i = 0; i < document.querySelectorAll("div").length; i++) {

document.querySelectorAll(`div`)[i].innerText = i;

}如果能够将元素集合赋值给 JavaScript 变量,每次通过变量去修改元素,那么性能将会得到不小的提升。

const divs = document.querySelectorAll("div");

for (let i = 0; i < divs.length; i++) {

divs[i].innerText = i;

}浏览器对比调试两者耗时可以看到,两者的渲染时间较为接近。但缓存元素的方式在黄色的 Scripting 耗时上具有明显优势。

高效操作 DOM 元素总结

本课时从深入理解 DOM 的必要性说起,然后分析了 DOM 操作耗时的原因,最后再针对这些原因提出了可行的解决方法。

除了这些方法之外,还有一些原则也可能帮助我们提升渲染性能,比如:

尽量不要使用复杂的匹配规则和复杂的样式,从而减少渲染引擎计算样式规则生成 CSSOM 树的时间;

尽量减少重排和重绘影响的区域;

使用 CSS3 特性来实现动画效果。

希望你首先能理解原因,然后记住这些方法和原则,编写出高性能代码。

最后布置一道思考题:说一说你还知道哪些提升渲染速度的方法和原则?

- 利用绝对定位 脱离文档流,这样操作定位里面的内容不会引起外部的重排

- 有动画的话,也可以考虑分层渲染的机制。加上 will-change

- dom 的操作进行 json 数据化,只操作一个根节点即可

3 个使用场景助你用好 DOM 事件

DOM 事件数量非常多,即使分类也有十多种,比如键盘事件、鼠标事件、表单事件等,而且不同事件对象属性也有差异,这带来了一定的学习难度。

但页面要与用户交互,接收用户输入,就离不开监听元素事件,所以,DOM 事件是前端工程师必须掌握的重要内容,同时也是 DOM 的重要组成部分。

下面我们就从防抖、节流、代理 3 个场景出发,详细了解 DOM 事件。

防抖

试想这样的一个场景,有一个搜索输入框,为了提升用户体验,希望在用户输入后可以立即展现搜索结果,而不是每次输入完后还要点击搜索按钮。最基本的实现方式应该很容易想到,那就是绑定 input 元素的键盘事件,然后在监听函数中发送 AJAX 请求。伪代码如下:

const ipt = document.querySelector("input");

ipt.addEventListener("input", (e) => {

search(e.target.value).then(

(resp) => {

// ...

},

(e) => {

// ...

}

);

});但其实这样的写法很容易造成性能问题。比如当用户在搜索“lagou”这个词的时候,每一次输入都会触发搜索:

搜索“l”

搜索“la”

搜索“lag”

搜索“lago”

搜索“lagou”

而实际上,只有最后一次搜索结果是用户想要的,前面进行了 4 次无效查询,浪费了网络带宽和服务器资源。

所以对于这类连续触发的事件,需要添加一个**“防抖”功能**,为函数的执行设置一个合理的时间间隔,避免事件在时间间隔内频繁触发,同时又保证用户输入后能即时看到搜索结果。

要实现这样一个功能我们很容易想到使用 setTimeout() 函数来让函数延迟执行。就像下面的伪代码,当每次调用函数时,先判断 timeout 实例是否存在,如果存在则销毁,然后创建一个新的定时器。

// 代码1

const ipt = document.querySelector("input");

let timeout = null;

ipt.addEventListener("input", (e) => {

if (timeout) {

clearTimeout(timeout);

timeout = null;

}

timeout = setTimeout(() => {

search(e.target.value).then(

(resp) => {

// ...

},

(e) => {

// ...

}

);

}, 500);

});问题确实是解决了,但这并不是最优答案,或者说我们需对这个防抖操作进行一些“优化”。

试想一下,如果另一个搜索框也需要添加防抖,是不是也要把 timeout 相关的代码再编写一次?而其实这个操作是完全可以抽取成公共函数的。

在抽取成公共函数的同时,还需要考虑更复杂的情况:

参数和返回值如何传递?

防抖化之后的函数是否可以立即执行?

防抖化的函数是否可以手动取消?

具体代码如下所示,首先将原函数作为参数传入 debounce() 函数中,同时指定延迟等待时间,返回一个新的函数,这个函数包含 cancel 属性,用来取消原函数执行。flush 属性用来立即调用原函数,同时将原函数的执行结果以 Promise 的形式返回。

// 代码2

const debounce = (func, wait = 0) => {

let timeout = null;

let args;

function debounced(...arg) {

args = arg;

if (timeout) {

clearTimeout(timeout);

timeout = null;

}

// 以Promise的形式返回函数执行结果

return new Promise((res, rej) => {

timeout = setTimeout(async () => {

try {

const result = await func.apply(this, args);

res(result);

} catch (e) {

rej(e);

}

}, wait);

});

}

// 允许取消

function cancel() {

clearTimeout(timeout);

timeout = null;

}

// 允许立即执行

function flush() {

cancel();

return func.apply(this, args);

}

debounced.cancel = cancel;

debounced.flush = flush;

return debounced;

};

// 防抖处理之后的事件绑定

const ipt = document.querySelector("input");

ipt.addEventListener(

"input",

debounce((e) => {

search(e.target.value).then(

(resp) => {

// ...

},

(e) => {

// ...

}

);

}, 500)

);我们在写代码解决当前问题的时候,最初只能写出像代码 1 那样满足需求的代码。但要成为高级工程师,就一定要将问题再深想一层,比如代码如何抽象成公共函数,才能得到较为完善的代码 2,从而自身得到成长。

关于防抖函数还有功能更丰富的版本,比如 lodash 的 debounce() 函数,有兴趣的话可以到 GitHub 上查阅资料。

节流

现在来考虑另外一个场景,一个左右两列布局的查看文章页面,左侧为文章大纲结构,右侧为文章内容。现在需要添加一个功能,就是当用户滚动阅读右侧文章内容时,左侧大纲相对应部分高亮显示,提示用户当前阅读位置。

这个功能的实现思路比较简单,滚动前先记录大纲中各个章节的垂直距离,然后监听 scroll 事件的滚动距离,根据距离的比较来判断需要高亮的章节。伪代码如下:

// 监听scroll事件

wrap.addEventListener("scroll", (e) => {

let highlightId = "";

// 遍历大纲章节位置,与滚动距离比较,得到当前高亮章节id

for (let id in offsetMap) {

if (e.target.scrollTop <= offsetMap[id].offsetTop) {

highlightId = id;

break;

}

}

const lastDom = document.querySelector(".highlight");

const currentElem = document.querySelector(`a[href="#${highlightId}"]`);

// 修改高亮样式

if (lastDom && lastDom.id !== highlightId) {

lastDom.classList.remove("highlight");

currentElem.classList.add("highlight");

} else {

currentElem.classList.add("highlight");

}

});功能是实现了,但这并不是最优方法,因为滚动事件的触发频率是很高的,持续调用判断函数很可能会影响渲染性能。实际上也不需要过于频繁地调用,因为当鼠标滚动 1 像素的时候,很有可能当前章节的阅读并没有发生变化。所以我们可以设置在指定一段时间内只调用一次函数,从而降低函数调用频率,这种方式我们称之为“节流”。

实现节流函数的过程和防抖函数有些类似,只是对于节流函数而言,有两种执行方式,在调用函数时执行最先一次调用还是最近一次调用,所以需要设置时间戳加以判断。我们可以基于 debounce() 函数加以修改,代码如下所示:

const throttle = (func, wait = 0, execFirstCall) => {

let timeout = null;

let args;

let firstCallTimestamp;

function throttled(...arg) {

if (!firstCallTimestamp) firstCallTimestamp = new Date().getTime();

if (!execFirstCall || !args) {

console.log("set args:", arg);

args = arg;

}

if (timeout) {

clearTimeout(timeout);

timeout = null;

}

// 以Promise的形式返回函数执行结果

return new Promise(async (res, rej) => {

if (new Date().getTime() - firstCallTimestamp >= wait) {

try {

const result = await func.apply(this, args);

res(result);

} catch (e) {

rej(e);

} finally {

cancel();

}

} else {

timeout = setTimeout(async () => {

try {

const result = await func.apply(this, args);

res(result);

} catch (e) {

rej(e);

} finally {

cancel();

}

}, firstCallTimestamp + wait - new Date().getTime());

}

});

}

// 允许取消

function cancel() {

clearTimeout(timeout);

args = null;

timeout = null;

firstCallTimestamp = null;

}

// 允许立即执行

function flush() {

cancel();

return func.apply(this, args);

}

throttled.cancel = cancel;

throttled.flush = flush;

return throttled;

};节流与防抖都是通过延迟执行,减少调用次数,来优化频繁调用函数时的性能。不同的是,对于一段时间内的频繁调用,防抖是延迟执行后一次调用,节流是延迟定时多次调用。 代理 下面的 HTML 代码是一个简单的无序列表,现在希望点击每个项目的时候调用 getInfo() 函数,当点击“编辑”时,调用一个 edit() 函数,当点击“删除”时,调用一个 del() 函数。

<ul class="list">

<li class="item" id="item1">项目1<span class="edit">编辑<span class="delete">删除</li>

<li class="item" id="item2">项目2<span class="edit">编辑<span class="delete" >删除</li>

<li class="item" id="item3">项目3<span class="edit">编辑<span class="delete">删除</li>

...

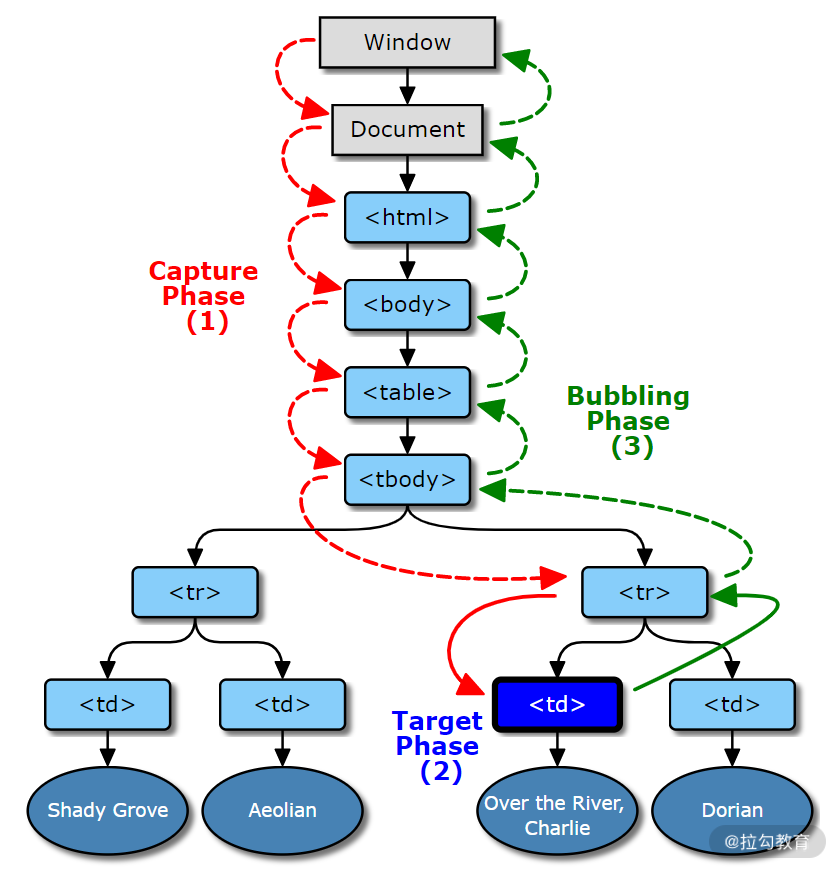

</ul>要实现这个功能并不难,只需要对列表中每一项,分别监听 3 个元素的 click 事件即可。 但如果数据量一旦增大,事件绑定占用的内存以及执行时间将会成线性增加,而其实这些事件监听函数逻辑一致,只是参数不同而已。此时我们可以以事件代理或事件委托来进行优化。不过在此之前,我们必须先复习一下 DOM 事件的触发流程。 事件触发流程如图 1 所示,主要分为 3 个阶段:

捕获,事件对象 Window 传播到目标的父对象,图 1 的红色过程;

目标,事件对象到达事件对象的事件目标,图 1 的蓝色过程;

冒泡,事件对象从目标的父节点开始传播到 Window,图 1 的绿色过程。

例如,在下面的代码中,虽然我们第二次进行事件监听时设置为捕获阶段,但点击事件时仍会按照监听顺序进行执行。

<body>

<button>click</button>

</body>

<script>

document.querySelector("button").addEventListener("click", function () {

console.log("bubble");

});

document.querySelector("button").addEventListener(

"click",

function () {

console.log("capture");

},

true

);

// 执行结果

// buble

// capture

</script>我们再回到事件代理,事件代理的实现原理就是利用上述 DOM 事件的触发流程来对一类事件进行统一处理。比如对于上面的列表,我们在 ul 元素上绑定事件统一处理,通过得到的事件对象来获取参数,调用对应的函数。

const ul = document.querySelector(".list");

ul.addEventListener("click", (e) => {

const t = e.target || e.srcElement;

if (t.classList.contains("item")) {

getInfo(t.id);

} else {

id = t.parentElement.id;

if (t.classList.contains("edit")) {

edit(id);

} else if (t.classList.contains("delete")) {

del(id);

}

}

});虽然这里我们选择了默认在冒泡阶段监听事件,但和捕获阶段监听并没有区别。对于其他情况还需要具体情况具体细分析,比如有些列表项目需要在目标阶段进行一些预处理操作,那么可以选择冒泡阶段进行事件代理。 补充:关于 DOM 事件标准 你知道下面 3 种事件监听方式的区别吗?

方式 1

<input type="text" onclick="click()" />方式 2

document.querySelector("input").onClick = function (e) {

// ...

};方式 3

document.querySelector("input").addEventListener("click", function (e) {

//...

});方式 1 和方式 2 同属于 DOM0 标准,通过这种方式进行事件监会覆盖之前的事件监听函数。

方式 3 属于 DOM2 标准,推荐使用这种方式。同一元素上的事件监听函数互不影响,而且可以独立取消,调用顺序和监听顺序一致。

点击这里下载示例代码:course/03 at master · yalishizhude/course (github.com)

DOM 事件 总结

最后布置一道思考题:你还能举出关于事件代理在开源项目中使用的例子吗?

掌握 CSS 精髓:布局

CSS 虽然初衷是用来美化 HTML 文档的,但实际上随着 float、position 等属性的出现,它已经可以起到调整文档渲染结构的作用了,而随着弹性盒子以及网格布局的推出,CSS 将承担越来越重要的布局功能。渐渐地我们发现 HTML 标签决定了页面的逻辑结构,而 CSS 决定了页面的视觉结构。

这一课时我们先来分析常见的布局效果有哪些,然后再通过代码来实现这些效果,从而帮助你彻底掌握 CSS 布局。

我们通常提到的布局,有两个共同点:

大多数用于 PC 端,因为 PC 端屏幕像素宽度够大,可布局的空间也大;

布局是有限空间内的元素排列方式,因为页面设计横向不滚动,纵向无限延伸,所以大多数时候讨论的布局都是对水平方向进行分割。

实际上我们在讨论布局的时候,会把网页上特定的区域进行分列操作。按照分列数目,可以大致分为 3 类,即单列布局、2 列布局、3 列布局。

单列布局

单列布局是最常用的一种布局,它的实现效果就是将一个元素作为布局容器,通常设置一个较小的(最大)宽度来保证不同像素宽度屏幕下显示一致。

一些网站会将单列布局与其他布局方式混合使用,比如拉勾网首页的海报和左侧标签就使用了 2 列布局,这样既能向下兼容窄屏幕,又能按照主次关系显示页面内容。

这种布局的优势在于基本上可以适配超过布局容器宽度的各种显示屏幕,比如上面的示例网站布局容器宽度为 700px,也就是说超过 700px 宽度的显示屏幕上浏览网站看到的效果是一致的。

但它最大的缺点也是源于此,过度的冗余设计必然会带来浪费。例如,在上面的例子中,其实我的屏幕宽度是足够的,可以显示更多的内容,但是页面两侧却出现了大量空白区域,如果在 4k 甚至更宽的屏幕下,空白区域大小会超过页面内容区域大小!

2 列布局

2 列布局使用频率也非常的高,实现效果就是将页面分割成左右宽度不等的两列,宽度较小的列设置为固定宽度,剩余宽度由另一列撑满。为了描述方便,我们暂且称宽度较小的列父元素为次要布局容器,宽度较大的列父元素为主要布局容器。

示例网站:各种文档网站

3 列布局(圣杯布局)

3 列布局按照左中右的顺序进行排列,通常中间列最宽,左右两列次之。

示例网站:

- github 登录后的首页。登录 GitHub 后,蓝色区域为宽度最大的中间列。

- CSDN 首页,这是 3 列布局的第二种实现方式,蓝色部分就是 2 列布局的主要布局容器,而它的子元素又使用了 2 列布局。

3 列布局和 2 列布局类似,也有明确的主次关系,只是关系层次增加了一层。下面我们来看看如何实现这些布局。

3 列布局的圣杯布局和双飞翼布局

- 圣杯布局:两边定宽,中间自适应的 3 列布局,中间列要放在文档流前面以优先渲染。

- 双飞翼布局的中间栏宽度可以缩小至 0

两者异同

两者的功能相同,都是为了实现一个两侧宽度固定,中间宽度自适应的三栏布局,并且中间部分在 HTML 代码中要写在前边,这样它就会被优先加载渲染。

主要的不同之处:在解决中间部分被挡住的问题时,采取的解决办法不一样。圣杯布局是在父元素上设置了 padding-left 和 padding-right,在给左右两边的内容设置 position 为 relative,通过左移和右移来使得左右两边的内容得以很好的展现,而双飞翼布局则是在中间这个 div 的外层又套了一个 div 来放置内容,在给这个中间的 div 设置 margin-left 和 margin-right 。

两种布局方式都是把主列放在文档流最前面,使主列优先加载。

两种布局方式在实现上也有相同之处,都是让三列浮动,然后通过负外边距形成三列布局。

两种布局方式的不同之处在于如何处理中间主列的位置:

- 圣杯布局是利用父容器的左、右内边距+两个列的相对定位;

- 双飞翼布局是把主列嵌套在一个新的父级块中并利用主列的左、右外边距进行布局调整。

布局实现

单列布局没有太多技术难点,通过将设置布局容器(最大)宽度以及左右边距为 auto 即可实现,我们重点讨论 2 列和 3 列布局。关于这两种布局,在网上可以找到很多实现方式,我们是不是只要把这些方式收集起来然后都记住就行了呢?

当然不是!

我们要做的是通过归纳法,找到这些方式的共同实现步骤,只要把这些步骤记住了,就能做到举一反三。

你可以试着自己先整理一下,或者直接看我整理好的结果。

要实现 2 列布局或 3 列布局,可以按照下面的步骤来操作:

(1)为了保证主要布局容器优先级,应将主要布局容器写在次要布局容器之前。

(2)将布局容器进行水平排列;

(3)设置宽度,即次要容器宽度固定,主要容器撑满;

(4)消除布局方式的副作用,如浮动造成的高度塌陷;

(5)为了在窄屏下也能正常显示,可以通过媒体查询进行优化。

根据以上操作步骤,先来看一个使用 flex 布局实现 2 列布局的例子。

第 1 步,写好 HTML 结构。这里为了查看方便,我们为布局容器设置背景颜色和高度。

<style>

/* 为了方便查看,给布局容器设置高度和颜色 */

main,

aside {

height: 100px;

}

main {

background-color: #f09e5a;

}

aside {

background-color: #c295cf;

}

</style>

<div>

<main>主要布局容器</main>

<aside>次要布局容器</aside>

</div>第 2 步,将布局容器水平排列:

<style>

.wrap {

display: flex;

flex-direction: row-reverse;

}

.main {

flex: 1;

}

.aside {

flex: 1;

}

</style>

<div class="wrap">

<main class="main">主要布局容器</main>

<aside class="aside">次要布局容器</aside>

</div>第 3 步,调整布局容器宽度:

<style>

.wrap {

display: flex;

flex-direction: row-reverse;

}

.main {

flex: 1;

}

.aside {

width: 200px;

}

</style>

<div class="wrap">

<main class="main">主要布局容器</main>

<aside class="aside">次要布局容器</aside>

</div>第 4 步,消除副作用,比如浮动造成的高度塌陷。由于使用 flex 布局没有副作用,所以不需要修改,代码和效果图同第 3 步。

第 5 步,增加媒体查询。

<style>

.wrap {

display: flex;

flex-direction: row-reverse;

flex-wrap: wrap;

}

.main {

flex: 1;

}

.aside {

width: 200px;

}

@media only screen and (max-width: 1000px) {

.wrap {

flex-direction: row;

}

.main {

flex: 100%;

}

}

</style>

<div class="wrap">

<main class="main">主要布局容器</main>

<aside class="aside">次要布局容器</aside>

</div>下面再来个复杂些的 3 列布局的例子。

第 1 步,写好 HTML 结构,为了辨认方便,我们给布局容器设置背景色和高度:

<style>

/* 为了方便查看,给布局容器设置高度和颜色 */

.main,

.left,

.right {

height: 100px;

}

.main {

background-color: red;

}

.left {

background-color: green;

}

.right {

background-color: blue;

}

</style>

<div class="wrap">

<main class="main">main</main>

<aside class="left">left</aside>

<aside class="right">right</aside>

</div>第 2 步,让布局容器水平排列:

<style>

.main,

.left,

.right {

float: left;

}

</style>

<div class="wrap">

<main class="main">main</main>

<aside class="left">left</aside>

<aside class="right">right</aside>

</div>第 3 步,调整宽度,将主要布局容器 main 撑满,次要布局容器 left 固定 300px,次要布局容器 right 固定 200px。

这里如果直接设置的话,布局容器 left 和 right 都会换行,所以我们需要通过设置父元素 wrap 内边距来压缩主要布局 main 给次要布局容器留出空间。同时通过设置次要布局容器边距以及采用相对定位调整次要布局容器至两侧。

<style>

.main,

.left,

.right {

float: left;

}

.wrap {

padding: 0 200px 0 300px;

}

.main {

width: 100%;

}

.left {

width: 300px;

position: relative;

left: -300px;

margin-left: -100%;

}

.right {

position: relative;

width: 200px;

margin-left: -200px;

right: -200px;

}

</style>

<div class="wrap">

<main class="main">main</main>

<aside class="left">left</aside>

<aside class="right">right</aside>

</div>第 4 步,消除副作用。我们知道使用浮动会造成高度塌陷,如果在父元素后面添加新的元素就会产生这个问题。所以可以通过伪类来清除浮动,同时减小页面宽度,还会发现次要布局容器 left 和 right 都换行了,但这个副作用我们可以在第 5 步时进行消除。

<style>

.main,

.left,

.right {

float: left;

}

.wrap {

padding: 0 200px 0 300px;

}

.wrap::after {

content: "";

display: block;

clear: both;

}

.main {

width: 100%;

}

.left {

width: 300px;

position: relative;

left: -300px;

margin-left: -100%;

}

.right {

position: relative;

width: 200px;

margin-left: -200px;

right: -200px;

}

</style>

<div class="wrap">

<main class="main">main</main>

<aside class="left">left</aside>

<aside class="right">right</aside>

</div>第 5 步,利用媒体查询调整页面宽度较小情况下的显示优先级。这里我们仍然希望优先显示主要布局容器 main,其次是次要布局容器 left,最后是布局容器 right。

<style>

.main,

.left,

.right {

float: left;

}

.wrap {

padding: 0 200px 0 300px;

}

.wrap::after {

content: "";

display: block;

clear: both;

}

.main {

width: 100%;

}

.left {

width: 300px;

position: relative;

left: -300px;

margin-left: -100%;

}

.right {

position: relative;

width: 200px;

margin-left: -200px;

right: -200px;

}

@media only screen and (max-width: 1000px) {

.wrap {

padding: 0;

}

.left {

left: 0;

margin-left: 0;

}

.right {

margin-left: 0;

right: 0;

}

}

</style>

<div class="wrap">

<main class="main">main</main>

<aside class="left">left</aside>

<aside class="right">right</aside>

</div>这种 3 列布局的实现,就是流传已久的**“圣杯布局”**,但标准的圣杯布局没有添加媒体查询。

延伸 1:垂直方向的布局

垂直方向有一种布局虽然使用频率不如水平方向布局高,但在面试中很容易被问到,所以这里特意再补充讲解一下。

这种布局将页面分成上、中、下三个部分,上、下部分都为固定高度,中间部分高度不定。当页面高度小于浏览器高度时,下部分应固定在屏幕底部;当页面高度超出浏览器高度时,下部分应该随中间部分被撑开,显示在页面最底部。

这种布局也称之为”sticky footer“,意思是下部分粘黏在屏幕底部。要实现这个功能,最简单的就是使用 flex 或 grid 进行布局。下面是使用 flex 的主要代码:

<style>

.container {

display: flex;

height: 100%;

flex-direction: column;

}

header,

footer {

min-height: 100px;

}

main {

flex: 1;

}

</style>

<div class="container">

<header></header>

<main>

<div>...</div>

</main>

<footer></footer>

</div>代码实现思路比较简单,将布局容器的父元素 display 属性设置成 flex,伸缩方向改为垂直方向,高度撑满页面,再将中间布局容器的 flex 属性设置为 1,让其自适应即可。

如果要考虑兼容性的话,其实现起来要复杂些,下面是主要代码:

<style>

.container {

box-sizing: border-box;

min-height: 100vh;

padding-bottom: 100px;

}

header,

footer {

height: 100px;

}

footer {

margin-top: -100px;

}

</style>

<div class="container">

<header></header>

<main></main>

</div>

<footer></footer>将上部分布局容器与中间布局容器放入一个共同的父元素中,并让父元素高度撑满,然后设置内下边距给下部分布局容器预留空间,下部分布局容器设置上外边距“嵌入”父元素中。从而实现了随着中间布局容器高度而被撑开的效果。

延伸 2:框架中栅格布局的列数

很多 UI 框架都提供了栅格系统来帮助页面实现等分或等比布局,比如 Bootstrap 提供了 12 列栅格,elment ui 和 ant design 提供了 24 列栅格。

那么你思考过栅格系统设定这些列数背后的原因吗?

首先从 12 列说起,12 这个数字,从数学上来说它具有很多约数 1、2、3、4、6、12,也就是说可以轻松实现 1 等分、2 等分、3 等分、4 等分、6 等分、12 等分,比例方面可以实现 1:11、1:5、1:3、1:2、1:1、1:10:1、1:4:1 等。如果换成 10 或 8,则可实现的等分比例就会少很多,而更大的 16 似乎是个不错的选择,但对于常用的 3 等分就难以实现。

至于使用 24 列不使用 12 列,可能是考虑宽屏幕(PC 端屏幕宽度不断增加)下对 12 列难以满足等分比例需求,比如 8 等分。同时又能够保证兼容 12 列情况下的等分比例(方便项目迁移和替换)。

CSS 布局总结

通过这一讲,我们学习了几种常见布局,包括单列、2 列、3 列及垂直三栏布局,同时思考每种布局的优缺点和使用场景,并且对 2 列布局和 3 列布局实现方法归纳成了 5 个步骤,希望你能举一反三,并应用到实际的工作中。

课程代码点击下载:https://github.com/yalishizhude/course/tree/master/04

最后布置一道思考题:你还想到了使用哪些方法来实现 2 列或 3 列布局?

如何管理你的 CSS 代码

从组织管理的角度探讨如何管理好项目中的 CSS 代码。

如何组织样式文件

尽管 CSS 提供了 import 命令支持文件引用,但由于其存在一些问题(比如影响浏览器并行下载、加载顺序错乱等)导致使用率极低。更常见的做法是通过预处理器或编译工具插件来引入样式文件,因此本课时的讨论将不局限于以 .css 为后缀的样式文件。

管理样式文件的目的就是为了让开发人员更方便地维护代码。

具体来说就是将样式文件进行分类,把相关的文件放在一起。让工程师在修改样式的时候更容易找到对应的样式文件,在创建样式文件的时候更容易找到对应的目录。

下面我们来看看热门的开源项目都是怎么来管理样式文件的。

开源项目中的样式文件

我们先来看看著名的 UI 相关的开源项目是怎么管理样式文件的。

以 Bootstrap为例,下图是项目样式代码结构,可以看出项目使用的是 Sass 预处理器。

该目录包括了 5 个目录、组件样式文件和一些全局样式。再来分析下目录及内容:

forms/,表单组件相关样式;

helpers/,公共样式,包括定位、清除等;

mixins/,可以理解为生成最终样式的函数;

utilities/,媒体查询相关样式;

vendor/,依赖的外部第三方样式。

根目录存放了组件样式文件和目录,其他样式文件放在不同的目录中。目录中的文件分类清晰,但目录结构相对于大多数实际项目而言过于简单(只有样式文件)。

我们再来看一个更符合大多数情况的开源项目 ant-design,该项目采用 Less 预处理器,主要源码放在 /components 目录下:

至于全局样式和公共样式则在 /components/style 目录下:

其中包括 4 个目录:

color/,颜色相关的变量与函数;

core/,全局样式,根标签样式、字体样式等;

mixins/,样式生成函数;

themes/,主题相关的样式变量。

将组件代码及相关样式放在一起,开发的时候修改会很方便。 但在组件目录 /comnponents 下设置 style 目录存放全局和公共样式,在逻辑上就有些说不通了,这些“样式”文件并不是一个单独的“组件”。再看 style 目录内部结构,相对于设置单独的 color 目录来管理样式中的颜色,更推荐像 Bootstrap 一样设立专门的目录或文件来管理变量。

最后来看看依赖 Vue.js 实现的热门 UI 库 element 的目录结构。项目根路径下的 packages 目录按组件划分目录来存放其源码,但和 ant-design 不同的是,组件样式文件并没有和组件代码放在一起。下图是 /packages 目录下的部分内容。

element 将样式文件统一放入了 /packages/theme-chalk 目录下:

其中包含 4 个目录:

common/,一些全局样式和公共变量;

date-picker/,日期组件相关样式;

fonts/,字体文件;

mixins/,样式生成函数及相关变量。

和 antd 有同样的问题,把样式当成“组件”看待,组件同级目录设立了 theme-chalk 目录存放样式文件。theme-chalk 目录下的全局样式 reset.scss 与组件样式同级,这也有些欠妥。这种为了将样式打包成模块,在独立项目中直接嵌入另一个独立项目(可以简单理解为一个项目不要有多个 package.json 文件)并不推荐,更符合 Git 使用规范的做法,即是以子模块的方式引用进项目。 而且将组件样式和源码分离这种方式开发的时候也不方便,经常需要跨多层目录查找和修改样式。

样式文件管理模式

除了开源项目之外,[Sass Guidelines](Sass Guidelines (sass-guidelin.es)) 曾经提出过一个用来划分样式文件目录结构的 7-1 模式也很有参考意义。这种模式建议将目录结构划分为 7 个目录和 1 个文件,这 1 个文件是样式的入口文件,它会将项目所用到的所有样式都引入进来,一般命名为 main.scss。

剩下的 7 个目录及作用如下:

base/,模板代码,比如默认标签样式重置;

components/,组件相关样式;

layout/,布局相关,包括头部、尾部、导航栏、侧边栏等;

pages/,页面相关样式;

themes/,主题样式,即使有的项目没有多个主题,也可以进行预留;

abstracts/,其他样式文件生成的依赖函数及 mixin,不能直接生成 css 样式;

vendors/,第三方样式文件。

示例项目地址:https://github.com/HugoGiraudel/sass-boilerplate

由于这个划分模式是专门针对使用 Sass 项目提出的,从样式文件名称看出还留有 jQuery 时代的影子,为了更加符合单页应用的项目结构,我们可以稍作优化。

main.scss 文件存在意义不大,页面样式、组件样式、布局样式都可以在页面和组件中引用,全局样式也可以在根组件中引用。而且每次添加、修改样式文件都需要在 main.scss 文件中同步,这种过度中心化的配置方式也不方便。

layout 目录也可以去除,因为像 footer、header 这些布局相关的样式,放入对应的组件中来引用会更好,至于不能被组件化的“_grid”样式存在性也不大。因为对于页面布局,既可以通过下面介绍的方法来拆分成全局样式,也可以依赖第三方 UI 库来实现。所以说这个目录可以去除。

themes/ 目录也可以去除,毕竟大部分前端项目是不需要设置主题的,即使有主题也可以新建一个样式文件来管理样式变量。

vendors/ 目录可以根据需求添加。因为将外部样式复制到项目中的情况比较少,更多的是通过 npm 来安装引入 UI 库或者通过 webpack 插件来写入对应的 cdn 地址。

所以优化后的目录结构如下所示:

src/

|

|– abstracts/

| |– _variables.scss

| |– _functions.scss

| |– _mixins.scss

| |– _placeholders.scss

|

|– base/

| |– _reset.scss

| |– _typography.scss

| …

|

|– components/

| |– _buttons.scss

| |– _carousel.scss

| |– _cover.scss

| |– _dropdown.scss

| |- header/

| |- header.tsx

| |- header.sass

| |- footer/

| |- footer.tsx

| |- footer.sass

| …

|

|– pages/

| |– _home.scss

| |– _contact.scss

| …

|这只是推荐的一种目录结构,具体使用可以根据实际情况进行调整。比如我在项目的 src 目录下创建了模块目录,按照模块来拆分路由以及页面、组件,所以每个模块目录下都会有 pages/ 目录和 components/ 目录。

如何避免样式冲突

由于 CSS 的规则是全局的,任何一个样式规则,都对整个页面有效,所以如果不对选择器的命名加以管控会很容易产生冲突。

手动命名

最简单有效的命名管理方式就是制定一些命名规则,比如 OOCSS:Object-oriented CSS (oocss.org)、BEM:BEM — Block Element Modifier (getbem.com)、AMCSS:AMCSS - Attribute Modules for CSS,其中推荐比较常用的 BEM。 这里简单补充一下 BEM 相关知识,熟悉 BEM 的可以直接跳过。

BEM 是 Block、Element、Modifier 三个单词的缩写,Block 代表独立的功能组件,Element 代表功能组件的一个组成部分,Modifier 对应状态信息。

看官方首页给出的示例代码:

BEM — Block Element Modifier (getbem.com)

从命名可以看到 Element 和 Modifier 是可选的,各个单词通过双横线(也可以用双下划线)连接(双横线虽然能和单词的连字符进行区分,但确实有些冗余,可以考虑直接用下划线代替)。BEM 的命名方式具有语义,很容易理解,非常适用于组件样式类。

工具命名

通过命名规范来避免冲突的方式固然是好的,但这种规范约束也不能绝对保证样式名的唯一性,而且也没有有效的校验工具来保证命名正确无冲突。所以,聪明的开发者想到了通过插件将原命名转化成不重复的随机命名,从根本上避免命名冲突。比较著名的解决方案就是 CSS Modules。 下面是一段 css 样式代码:

/* style.css */

.className {

color: green;

}借助 css Modules 插件,可以将 css 以 JSON 对象的形式引用和使用。

import styles from "./style.css";

// import { className } from "./style.css";

element.innerHTML = '<div class="' + styles.className + '">';编译之后的代码,样式类名被转化成了随机名称:

<div class="_3zyde4l1yATCOkgn-DBWEL"></div>

<style>

._3zyde4l1yATCOkgn-DBWEL {

color: green;

}

</style>但这种命名方式带来了一个问题,那就是如果想在引用组件的同时,覆盖它的样式会变得困难,因为编译后的样式名是随机。例如,在上面的示例代码中,如果想在另一个组件中覆盖 className 样式就很困难,而在手动命名情况下则可以直接重新定义 className 样式进行覆盖。

如何高效复用样式

如果你有一些项目开发经历,一定发现了某些样式会经常被重复使用,比如:

display:inline-block

clear:both

position:relative

......

这违背了 DRY(Don't Repeat Yourself)原则,完全可以通过设置为全局公共样式来减少重复定义。 哪些样式规则可以设置为全局公共样式呢?

首先是具有枚举值的属性,除了上面提到的,还包括 cursor:pointer、float:left 等。

其次是那些特定数值的样式属性值,比如 margin: 0、left: 0、height: 100%。

最后是设计规范所使用的属性,比如设计稿中规定的几种颜色。

样式按照小粒度拆分之后命名规范也很重要,合理的命名规范可以避免公共样式重复定义,开发时方便快速引用。

前面提到的语义化命名方式 BEM 显然不太适合。首先全局样式是基于样式属性和值的,是无语义的;其次对于这种复用率很高的样式应该尽量保证命名简短方便记忆,所以推荐使用更简短、更方便记忆的命名规则。比如我们团队所使用的就是“属性名首字母 + 横线 + 属性值首字母”的方式进行命名。

举个例子,比如对于 display:inline-block 的样式属性值,它的属性为“display”缩写为“d”,值为“inline-block”,缩写为“ib”,通过短横线连接起来就可以命名成“d-ib”;同样,如果工程师想设置一个 float:left 的样式,也很容易想到使用“f-l”的样式名。

那会不会出现重复定义呢?这个问题很好解决,按照字母序升序定义样式类就可以了。

延伸:值得关注的 CSS in JavaScript

我们都知道 Web 标准提倡结构、样式、行为分离(分别对应 HTML、CSS、JavaScript 三种语言),但 React.js 的一出现就开始颠覆了这个原则。

先是通过 JSX 将 HTML 代码嵌入进 JavaScript 组件,然后又通过 CSS in JavaScript 的方式将 CSS 代码也嵌入进 JavaScript 组件。这种“all in JavaScript”的方式确实有悖 Web 标准。但这种编写方式和日益盛行的组件化概念非常契合,具有“高内聚”的特性,所以未来标准有所改变也未尝不可能。这也正是我们需要关注 CSS in JavaScript 技术的原因。

相对于使用预处理语言编写样式,CSS in JavaScript 具有两个不那么明显的优势:

- 可以通过随机命名解决作用域问题,但命名规则和 CSS Modules 都可以解决这个问题;

- 样式可以使用 JavaScript 语言特性,比如函数、循环,实现元素不同的样式效果可以通过新建不同样式类,修改元素样式类来实现。

我们以 styled-compoents 为例进行说明,下面是示例代码,第一段是源代码:

// 源代码 const Button = styled.button` background: transparent; border-radius:

3px; border: 2px solid palevioletred; color: palevioletred; margin: 0.5em 1em;

padding: 0.25em 1em; ${props => props.primary && css` background: palevioletred;

color: white; `} `; const Container = styled.div` text-align: center; ` render(

<Container>

<button>Normal Button</button>

<button primary>Primary Button</button>

</Container>

);第二段是编译后生成的:

<!--HTML 代码-->

<div class="sc-fzXfNJ ciXJHl">

<button class="sc-fzXfNl hvaMnE">Normal Button</button>

<button class="sc-fzXfNl kiyAbM">Primary Button</button>

</div>

/*CSS 代码*/ .ciXJHl { text-align: center; } .hvaMnE { color: palevioletred;

background: transparent; border-radius: 3px; border-width: 2px; border-style:

solid; border-color: palevioletred; border-image: initial; margin: 0.5em 1em;

padding: 0.25em 1em; } .kiyAbM { color: white; border-radius: 3px; border-width:

2px; border-style: solid; border-color: palevioletred; border-image: initial;

margin: 0.5em 1em; padding: 0.25em 1em; background: palevioletred; }对比以上两段代码很容易发现,在编译后的样式代码中有很多重复的样式规则。这并不友好,不仅增加了编写样式的复杂度和代码量,连编译后也增加了冗余代码。

styled-components 只是 CSS in JavaScript 的一种解决方案,其他解决方案还有很多,有兴趣的同学可以点击这里查阅 GitHub 上的资料学习,上面收录了现有的 CSS in JavaScript 解决方案。

如何管理 CSS 代码总结

对于样式文件的管理,推荐使用 7-1 模式简化后的目录结构,包括 pages/、components/、abastracts/、base/ 4 个目录。对于样式命名,可以采用 BEM 来命名组件、面向属性的方式来命名公共样式。

最后留一道思考题:说说你在项目中是如何管理样式代码的?

浏览器如何渲染页面

结合代码实例为你讲解浏览器渲染页面时的流程和步骤。 先来看一个例子,假如我们在浏览器中输入了一个网址,得到了下面的 html 文件,渲染引擎是怎样通过解析代码生成页面的呢?

<html>

<head> </head>

<body>

lagou

</body>

</html>从 HTML 到 DOM

字节流解码

对于上面的代码,我们看到的是它的字符形式。而浏览器通过 HTTP 协议接收到的文档内容是字节数据,下图是抓包工具截获的报文截图,报文内容为左侧高亮显示的区域(为了查看方便,该工具将字节数据以十六进制方式显示)。当浏览器得到字节数据后,通过“编码嗅探算法”来确定字符编码,然后根据字符编码将字节流数据进行解码,生成截图右侧的字符数据,也就是我们编写的代码。 这个把字节数据解码成字符数据的过程称之为“字节流解码”。

我们通过浏览器调试工具查看网络请求时,也是经过了上述操作过程,才能直观地看到字符串。 2. ##### 输入流预处理

通过上一步解码得到的字符流数据在进入解析环节之前还需要进行一些预处理操作。比如将换行符转换成统一的格式,最终生成规范化的字符流数据,这个把字符数据进行统一格式化的过程称之为“输入流预处理”。 3. ##### 令牌化

经过前两步的数据解码和预处理,下面就要进入重要的解析步骤了。 解析包含两步,第一步是将字符数据转化成令牌(Token),第二步是解析 HTML 生成 DOM 树。先来说说令牌化,其过程是使用了一种类似状态机的算法,即每次接收一个或多个输入流中的字符;然后根据当前状态和这些字符来更新下一个状态,也就是说在不同的状态下接收同样的字符数据可能会产生不同的结果,比如当接收到“body”字符串时,在标签打开状态会解析成标签,在标签关闭状态则会解析成文本节点。 这个算法的解析规则较多,在此就不一一列举了,有兴趣的同学可以通过下面这个简单的例子来理解其原理。 上述 html 代码的标记过程如下:

初始化为“数据状态”(Data State);

匹配到字符 <,状态切换到 “标签打开状态”(Tag Open State);

匹配到字符 !,状态切换至 “标签声明打开状态”(Markup Declaration Open State),后续 7 个字符可以组成字符串 DOCTYPE,跳转到 “DOCTYPE 状态”(DOCTYPE State);

匹配到字符为空格,当前状态切换至 “DOCTYPE 名称之前状态”(Before DOCTYPE Name State);

匹配到字符串 html,创建一个新的 DOCTYPE 标记,标记的名字为 “html” ,然后当前状态切换至 “DOCTYPE 名字状态”(DOCTYPE Name State);

匹配到字符 >,跳转到 “数据状态” 并且释放当前的 DOCTYPE 标记;

匹配到字符 <,切换到 “标签打开状态”;

匹配到字符 h,创建一个新的起始标签标记,设置标记的标签名为空,当前状态切换至 “标签名称状态”(Tag Name State);

从字符 h 开始解析,将解析的字符一个一个添加到创建的起始标签标记的标签名中,直到匹配到字符 >,此时当前状态切换至 “数据状态” 并释放当前标记,当前标记的标签名为 “html” 。

解析后续的 的方式与 一致,创建并释放对应的起始标签标记,解析完毕后,当前状态处于 “数据状态” ;

匹配到字符串 “标记” ,针对每一个字符,创建并释放一个对应的字符标记,解析完毕后,当前状态仍然处于 “数据状态” ;

匹配到字符 <,进入 “标签打开状态” ;

匹配到字符 /,进入 “结束标签打开状态”(End Tag Open State);

匹配到字符 b,创建一个新的结束标签标记,设置标记的标签名为空,当前状态切换至“标签名称状态”(Tag Name State);

重新从字符 b 开始解析,将解析的字符一个一个添加到创建的结束标签标记的标签名中,直到匹配到字符 >,此时当前状态切换至 “数据状态” 并释放当前标记,当前标记的标签名为 “body”;

解析 的方式与 一样;

所有的 html 标签和文本解析完成后,状态切换至 “数据状态” ,一旦匹配到文件结束标志符(EOF),则释放 EOF 标记。

最终生成类似下面的令牌结构:

开始标签:html

开始标签:head

结束标签:head

开始标签:body

字符串:lagou

结束标签:body

结束标签:html补充 1:遇到 script 标签时的处理

如果在 HTML 解析过程中遇到 script 标签,则会发生一些变化。

如果遇到的是内联代码,也就是在 script 标签中直接写代码,那么解析过程会暂停,执行权限会转给 JavaScript 脚本引擎,待 JavaScript 脚本执行完成之后再交由渲染引擎继续解析。有一种情况例外,那就是脚本内容中调用了改变 DOM 结构的 document.write() 函数,此时渲染引擎会回到第二步,将这些代码加入字符流,重新进行解析。

如果遇到的是外链脚本,那么渲染引擎会按照我们在第 01 课时中所述的,根据标签属性来执行对应的操作。

构建 DOM 树

解析 HTML 的第二步是树构建。

浏览器在创建解析器的同时会创建一个 Document 对象。在树构建阶段,Document 会作为根节点被不断地修改和扩充。标记步骤产生的令牌会被送到树构建器进行处理。HTML 5 标准中定义了每类令牌对应的 DOM 元素,当树构建器接收到某个令牌时就会创建该令牌对应的 DOM 元素并将该元素插入到 DOM 树中。 为了纠正元素标签嵌套错位的问题和处理未关闭的元素标签,树构建器创建的新 DOM 元素还会被插入到一个开放元素栈中。

树构建算法也可以采用状态机的方式来描述,具体我们以步骤 1 的 HTML 代码为例进行举例说明。

进入初始状态 “initial” 模式;

树构建器接收到 DOCTYPE 令牌后,树构建器会创建一个 DocumentType 节点附加到 Document 节点上,DocumentType 节点的 name 属性为 DOCTYPE 令牌的名称,切换到 “before html” 模式;

接收到令牌 html 后,树构建器创建一个 html 元素并将该元素作为 Document 的子节点插入到 DOM 树中和开放元素栈中,切换为 “before head” 模式;

虽然没有接收到 head 令牌,但仍然会隐式地创建 head 元素并加到 DOM 树和开放元素栈中,切换到“in head”模式;

将开放元素栈中的 head 元素弹出,进入 “after head”模式;

接收到 body 令牌后,会创建一个 body 元素插入到 DOM 树中同时压入开放元素栈中,当前状态切换为 “in body” 模式;

接收到字符令牌,创建 Text 节点,节点值为字符内容“标记”,将 Text 节点作为 body 元素节点插入到 DOM 树中;

接收到结束令牌 body,将开放元素栈中的 body 元素弹出,切换至 “after body” 模式;

接收到结束令牌 html,将开放元素栈中的 html 元素弹出,切换至 “after after body” 模式;

接收到 EOF 令牌,树构建器停止构建,html 文档解析过程完成。

最终生成下面的 DOM 树结构:

Document

/ \

DocumentType HTMLHtmlElement

/ \

HTMLHeadElement HTMLBodyElement

|

TextNode补充 2:从 CSS 到 CSSOM

渲染引擎除了解析 HTML 之外,也需要解析 CSS。

CSS 解析的过程与 HTML 解析过程步骤一致,最终也会生成树状结构。

与 DOM 树不同的是,CSSOM 树的节点具有继承特性,也就是会先继承父节点样式作为当前样式,然后再进行补充或覆盖。下面举例说明。

body {

font-size: 12px;

}

p {

font-weight: light;

}

span {

color: blue;

}

p span {

display: none;

}

img {

float: left;

}对于上面的代码,会解析生成类似下面结构的 DOM 树:

图片

需要注意的是,上图中的 CSSOM 树并不完整,完整的 CSSOM 树还应当包括浏览器提供的默认样式(也称为“User Agent 样式”)。

从 DOM 到渲染

有了 DOM 树和 CSSOM 树之后,渲染引擎就可以开始生成页面了。

构建渲染树

DOM 树包含的结构内容与 CSSOM 树包含的样式规则都是独立的,为了更方便渲染,先需要将它们合并成一棵渲染树。

这个过程会从 DOM 树的根节点开始遍历,然后在 CSSOM 树上找到每个节点对应的样式。

遍历过程中会自动忽略那些不需要渲染的节点(比如脚本标记、元标记等)以及不可见的节点(比如设置了“display:none”样式)。同时也会将一些需要显示的伪类元素加到渲染树中。

对于上面的 HTML 和 CSS 代码,最终生成的渲染树就只有一个 body 节点,样式为 font-size:12px。 6. ##### 布局

生成了渲染树之后,就可以进入布局阶段了,布局就是计算元素的大小及位置。

计算元素布局是一个比较复杂的操作,因为需要考虑的因素有很多,包括字体大小、换行位置等,这些因素会影响段落的大小和形状,进而影响下一个段落的位置。

布局完成后会输出对应的“盒模型”,它会精确地捕获每个元素的确切位置和大小,将所有相对值都转换为屏幕上的绝对像素。 7. ##### 绘制

绘制就是将渲染树中的每个节点转换成屏幕上的实际像素的过程。得到布局树这份“施工图”之后,渲染引擎并不能立即绘制,因为还不知道绘制顺序,如果没有弄清楚绘制顺序,那么很可能会导致页面被错误地渲染。 例如,对于使用 z-index 属性的元素(如遮罩层)如果未按照正确的顺序绘制,则将导致渲染结果和预期不符(失去遮罩作用)。

所以绘制过程中的第一步就是遍历布局树,生成绘制记录,然后渲染引擎会根据绘制记录去绘制相应的内容。 对于无动画效果的情况,只需要考虑空间维度,生成不同的图层,然后再把这些图层进行合成,最终成为我们看到的页面。当然这个绘制过程并不是静态不变的,会随着页面滚动不断合成新的图形。

浏览器如何渲染页面总结

这一课时主要讲解了浏览器渲染引擎生成页面的 7 个步骤,前面 4 个步骤为 DOM 树的生成过程,后面 3 个步骤是利用 DOM 树和 CSSOM 树来渲染页面的过程。我们想要理解和记忆这些过程其实很简单,那就是以数据变化为线索,具体来说数据的变化过程为:

字节 → 字符 → 令牌 → 树 → 页面最后布置一道思考题:在构建渲染树的时候,渲染引擎需要遍历 DOM 树节点并从 CSSOM 树中找到匹配的样式规则,在匹配过程中是通过自上而下还是自下而上的方式呢?为什么?

答:浏览器进行 CSS 选择器匹配时,是从右向左进行的,所以可以推知是自下而上

JavaScript 的数据类型

数据类型通常是一门编程语言的基础知识,JavaScript 的数据类型可以分为 7 种:空(Null)、未定义(Undefined)、数字(Number)、字符串(String)、布尔值(Boolean)、符号(Symbol)、对象(Object)。

其中前 6 种类型为基础类型,最后 1 种为引用类型。这两者的区别在于,基础类型的数据在被引用或拷贝时,是值传递,也就是说会创建一个完全相等的变量;而引用类型只是创建一个指针指向原有的变量,实际上两个变量是“共享”这个数据的,并没有重新创建一个新的数据。

下面我们就来分别介绍这 7 种数据类型的重要概念及常见操作。

Undefined

Undefined 是一个很特殊的数据类型,它只有一个值,也就是 undefined。可以通过下面几种方式来得到 undefined:

引用已声明但未初始化的变量;

引用未定义的对象属性;

执行无返回值函数;

执行 void 表达式;

全局常量 window.undefined 或 undefined。

对应代码如下:

var a; // undefined

var o = {};

o.b(

// undefined

() => {}

)(); // undefined

void 0; // undefined

window.undefined; // undefined其中比较推荐通过 void 表达式来得到 undefined 值,因为这种方式既简便(window.undefined 或 undefined 常量的字符长度都大于 "void 0" 表达式)又不需要引用额外的变量和属性;同时它作为表达式还可以配合三目运算符使用,代表不执行任何操作。

如下面的代码就表示满足条件 x 大于 0 且小于 5 的时候执行函数 fn,否则不进行任何操作:

x > 0 && x < 5 ? fn() : void 0;如何判断一个变量的值是否为 undefined 呢?

下面的代码给出了 3 种方式来判断变量 x 是否为 undefined,你可以先思考一下哪一种可行。

方式 1 直接通过逻辑取非操作来将变量 x 强制转换为布尔值进行判断;

- js

// 方式1 if(!x) { ... } 方式 2 通过 3 个等号将变量 x 与 undefined 做真值比较;

- js

// 方式2 if(x===undefined) { ... } 方式 3 通过 typeof 关键字获取变量 x 的类型,然后与 'undefined' 字符串做真值比较:

js// 方式2 if(typeof x === 'undefined') { ... }

现在来揭晓答案,

方式 1 不可行,因为只要变量 x 的值为 undefined、空字符串、数值 0、null 时都会判断为真。

方式 2 也存在一些问题,虽然通过 “===” 和 undefined 值做比较是可行的,但如果 x 未定义则会抛出错误 “ReferenceError: x is not defined” 导致程序执行终止,这对于代码的健壮性显然是不利的。

方式 3 则解决了这一问题。

Null

Null 数据类型和 Undefined 类似,只有唯一的一个值 null,都可以表示空值,甚至我们通过 “==” 来比较它们是否相等的时候得到的结果都是 true,但 null 是 JavaScript 保留关键字,而 undefined 只是一个常量。

也就是说我们可以声明名称为 undefined 的变量(虽然只能在老版本的 IE 浏览器中给它重新赋值),但将 null 作为变量使用时则会报错。

Boolean

Boolean 数据类型只有两个值:true 和 false,分别代表真和假,理解和使用起来并不复杂。但是我们常常会将各种表达式和变量转换成 Boolean 数据类型来当作判断条件,这时候就要注意了。

下面是一个简单地将星期数转换成中文的函数,比如输入数字 1,函数就会返回“星期一”,输入数字 2 会返回“星期二”,以此类推,如果未输入数字则返回 undefined。

function getWeek(week) {

const dict = ["日", "一", "二", "三", "四", "五", "六"];

if (week) return `星期${dict[week]}`;

}这里在 if 语句中就进行了类型转换,将 week 变量转换成 Boolean 数据类型,而 0、空字符串、null、undefined 在转换时都会返回 false。所以这段代码在输入 0 的时候不会返回“星期日”,而返回 undefined。

我们在做强制类型转换的时候一定要考虑这个问题。

Number

两个重要值

Number 是数值类型,有 2 个特殊数值得注意一下,即 NaN 和 Infinity。

- NaN(Not a Number)通常在计算失败的时候会得到该值。要判断一个变量是否为 NaN,则可以通过 Number.isNaN 函数进行判断。

- Infinity 是无穷大,加上负号 “-” 会变成无穷小,在某些场景下比较有用,比如通过数值来表示权重或者优先级,Infinity 可以表示最高优先级或最大权重。

进制转换

当我们需要将其他进制的整数转换成十进制显示的时候可以使用 parseInt 函数,该函数第一个参数为数值或字符串,第二个参数为进制数,默认为 10,当进制数转换失败时会返回 NaN。所以,如果在数组的 map 函数的回调函数中直接调用 parseInt,那么会将数组元素和索引值都作为参数传入。

["0", "1", "2"].map(parseInt); // [0, NaN, NaN]而将十进制转换成其他进制时,可以通过 toString 函数来实现。

(10).toString(2); // "1010"精度问题

对于数值类型的数据,还有一个比较值得注意的问题,那就是精度问题,在进行浮点数运算时很容易碰到。比如我们执行简单的运算 0.1 + 0.2,得到的结果是 0.30000000000000004,如果直接和 0.3 作相等判断时就会得到 false。

0.1 + 0.2; // 0.30000000000000004出现这种情况的原因在于计算的时候,JavaScript 引擎会先将十进制数转换为二进制,然后进行加法运算,再将所得结果转换为十进制。在进制转换过程中如果小数位是无限的,就会出现误差。同样的,对于下面的表达式,将数字 5 开方后再平方得到的结果也和数字 5 不相等。

Math.pow(Math.pow(5, 1 / 2), 2); // 5.000000000000001对于这个问题的解决方法也很简单,那就是消除无限小数位。

- 一种方式是先转换成整数进行计算,然后再转换回小数,这种方式适合在小数位不是很多的时候。比如一些程序的支付功能 API 以“分”为单位,从而避免使用小数进行计算。

- 还有另一种方法就是舍弃末尾的小数位。比如对上面的加法就可以先调用 toPrecision 截取 12 位,然后调用 parseFloat 函数转换回浮点数。

parseFloat((0.1 + 0.2).toPrecision(12)); // 0.3String

String 类型是最常用的数据类型了,关于它的基础 API 函数大家应该比较熟悉了,这里我就不多介绍了。下面通过一道笔试题来重点介绍它的使用场景。

千位分隔符是指为了方便识别较大数字,每隔三位数会加入 1 个逗号,该逗号就是千位分隔符。如果要编写一个函数来为输入值的数字添加千分位分隔符,该怎么实现呢?

一种很容易想到的方法就是从右往左遍历数值每一位,每隔 3 位添加分隔符。为了操作方便,我们可以将数值转换成字符数组,而要实现从右往左遍历,一种实现方式是通过 for 循环的索引值找到对应的字符;而另一种方式是通过数组反转,从而变成从左到右操作。

function sep(n) {

let [i, c] = n.toString().split(/(\.\d+)/);

return (

i

.split("")

.reverse()

.map((c, idx) => ((idx + 1) % 3 === 0 ? "," + c : c))

.reverse()

.join("")

.replace(/^,/, "") + c

);

}这种方式就是将字符串数据转化成引用类型数据,即用数组来实现。

第二种方式则是通过引用类型,即用正则表达式对字符进行替换来实现。

function sep2(n) {

let str = n.toString();

str.indexOf(".") < 0 ? (str += ".") : void 0;

return str.replace(/(\d)(?=(\d{3})+\.)/g, "$1,").replace(/\.$/, "");

}Symbol

Symbol 是 ES6 中引入的新数据类型,它表示一个唯一的常量,通过 Symbol 函数来创建对应的数据类型,创建时可以添加变量描述,该变量描述在传入时会被强行转换成字符串进行存储。

var a = Symbol("1");

var b = Symbol(1);

a.description === b.description; // true

var c = Symbol({ id: 1 });

c.description; // [object Object]

var _a = Symbol("1");

_a == a; // false基于上面的特性,Symbol 属性类型比较适合用于两类场景中:常量值和对象属性。

避免常量值重复

假设有个 getValue 函数,根据传入的字符串参数 key 执行对应代码逻辑。代码如下所示:

function getValue(key) {

switch(key){

case 'A':

...

...

case 'B':

...

}

}

getValue('B');这段代码对调用者而言非常不友好,因为代码中使用了魔术字符串(魔术字符串是指在代码之中多次出现、与代码形成强耦合的某一个具体的字符串或者数值),导致调用 getValue 函数时需要查看函数源码才能找到参数 key 的可选值。所以可以将参数 key 的值以常量的方式声明出来。

const KEY = {

alibaba: 'A',

baidu: 'B',

...

}

function getValue(key) {

switch(key){

case KEY.alibaba:

...

...

case KEY.baidu:

...

}

}

getValue(KEY.baidu);但这样也并非完美,假设现在我们要在 KEY 常量中加入一个 key,根据对应的规则,很有可能会出现值重复的情况:

const KEY = {

alibaba: 'A',

baidu: 'B',

...

bytedance: 'B'

}这显然会出现问题:

getValue(KEY.baidu); // 等同于 getValue(KEY.bytedance)所以在这种场景下更适合使用 Symbol,我们不关心值本身,只关心值的唯一性。

const KEY = {

alibaba: Symbol(),

baidu: Symbol(),

...

bytedance: Symbol()

}避免对象属性覆盖

假设有这样一个函数 fn,需要对传入的对象参数添加一个临时属性 user,但可能该对象参数中已经有这个属性了,如果直接赋值就会覆盖之前的值。此时就可以使用 Symbol 来避免这个问题。

创建一个 Symbol 数据类型的变量,然后将该变量作为对象参数的属性进行赋值和读取,这样就能避免覆盖的情况,示例代码如下:

function fn(o) { // {user: {id: xx, name: yy}}

const s = Symbol()

o[s] = 'zzz'

...

}补充:类型转换

什么是类型转换?

JavaScript 这种弱类型的语言,相对于其他高级语言有一个特点,那就是在处理不同数据类型运算或逻辑操作时会强制转换成同一数据类型。如果我们不理解这个特点,就很容易在编写代码时产生 bug。

通常强制转换的目标数据类型为 String、Number、Boolean 这三种。下面的表格中显示了 6 种基础数据类型转换关系。

除了不同类型的转换之外,操作同种数据类型也会发生转换。把基本类型的数据换成对应的对象过程称之为“装箱转换”,反过来,把数据对象转换为基本类型的过程称之为“拆箱转换”。

对于装箱和拆箱转换操作,我们既可以显示地手动实现,比如将 Number 数据类型转换成 Number 对象;也可以通过一些操作触发浏览器显式地自动转换,比如将对 Number 对象进行加法运算。

var n = 1;

var o = new Number(n); // 显式装箱

o.valueOf(); // 显式拆箱

n.toPrecision(3); // 隐式装箱, 实际操作:var tmp = new Number(n);tmp.toPrecision(3);tmp = null;

o + 2; // 隐式拆箱,实际操作:var tmp = o.valueOf();tmp + 2;tmp = null;什么时候会触发类型转换?

下面这些常见的操作会触发隐式地类型转换,我们在编写代码的时候一定要注意。

运算相关的操作符包括 +、-、+=、++、* 、/、%、<<、& 等。

数据比较相关的操作符包括 >、<、== 、<=、>=、===。

逻辑判断相关的操作符包括 &&、!、||、三目运算符。

Object

相对于基础类型,引用类型 Object 则复杂很多。简单地说,Object 类型数据就是键值对的集合,键是一个字符串(或者 Symbol) ,值可以是任意类型的值; 复杂地说,Object 又包括很多子类型,比如 Date、Array、Set、RegExp。

对于 Object 类型,我们重点理解一种常见的操作,即深拷贝。

- 由于引用类型在赋值时只传递指针,这种拷贝方式称为浅拷贝。

- 而创建一个新的与之相同的引用类型数据的过程称之为深拷贝。

现在我们来实现一个拷贝函数,支持上面 7 种类型的数据拷贝。

对于 6 种基础类型,我们只需简单的赋值即可,而 Object 类型变量需要特殊操作。因为通过等号“=”赋值只是浅拷贝,要实现真正的拷贝操作则需要通过遍历键来赋值对应的值,这个过程中如果遇到 Object 类型还需要再次进行遍历。

为了准确判断每种数据类型,我们可以先通过 typeof 来查看每种数据类型的描述:

[undefined, null, true, "", 0, Symbol(), {}].map((it) => typeof it); // ["undefined", "object", "boolean", "string", "number", "symbol", "object"]发现 null 有些特殊,返回结果和 Object 类型一样都为"object",所以需要再次进行判断。按照上面分析的结论,我们可以写出下面的函数:

function clone(data) {

let result = {};

const keys = [

...Object.getOwnPropertyNames(data),

...Object.getOwnPropertySymbols(data),

];

if (!keys.length) return data;

keys.forEach((key) => {

let item = data[key];

if (typeof item === "object" && item) {

result[key] = clone(item);

} else {

result[key] = item;

}

});

return result;

}在遍历 Object 类型数据时,我们需要把 Symbol 数据类型也考虑进来,所以不能通过 Object.keys 获取键名或 for...in 方式遍历,而是通过 getOwnPropertyNames 和 getOwnPropertySymbols 函数将键名组合成数组,然后进行遍历。对于键数组长度为 0 的非 Object 类型的数据可直接返回,然后再遍历递归,最终实现拷贝。

我们在编写递归函数的时候需要特别注意的是,递归调用的终止条件,避免无限递归。那在这个 clone 函数中有没有可能出现无限递归调用呢?

答案是有的。那就是当对象数据嵌套的时候,比如像下面这种情况,对象 a 的键 b 指向对象 b,对象 b 的键 a 指向对象 a,那么执行 clone 函数就会出现死循环,从而耗尽内存。

var a = {

var b = {}

a.b = b

b.a = a怎么避免这种情况呢?一种简单的方式就是把已添加的对象记录下来,这样下次碰到相同的对象引用时,直接指向记录中的对象即可。要实现这个记录功能,我们可以借助 ES6 推出的 WeakMap 对象,该对象是一组键/值对的集合,其中的键是弱引用的。其键必须是对象,而值可以是任意的。

我们对 clone 函数改造一下,添加一个 WeakMap 来记录已经拷贝过的对象,如果当前对象已经被拷贝过,那么直接从 WeakMap 中取出,否则重新创建一个对象并加入 WeakMap 中。具体代码如下:

function clone(obj) {

let map = new WeakMap();

function deep(data) {

let result = {};

const keys = [

...Object.getOwnPropertyNames(data),

...Object.getOwnPropertySymbols(data),

];

if (!keys.length) return data;

const exist = map.get(data);

if (exist) return exist;

map.set(data, result);

keys.forEach((key) => {

let item = data[key];

if (typeof item === "object" && item) {

result[key] = deep(item);

} else {

result[key] = item;

}

});

return result;

}

return deep(obj);

}JavaScript 数据类型总结

这一课时通过实例与原理相结合,带你深入理解了 JavaScript 的 6 种基础数据类型和 1 种引用数据类型。对于 6 种基础数据类型,我们要熟知它们之间的转换关系,而引用类型则比较复杂,重点讲了如何深拷贝一个对象。其实引用对象的子类型比较多,由于篇幅所限没有进行一一讲解,需要大家在平常工作中继续留心积累。

值类型(基本类型):字符串(String)、数字(Number)、布尔(Boolean)、对空(Null)、未定义(Undefined)、Symbol。引用数据类型:对象(Object)、数组(Array)、函数(Function)。

最后布置一道思考题:你能否写出一个函数来判断两个变量是否相等?

为什么说函数是 JavaScript 的一等公民?

数据类型与函数是很多高级语言中最重要的两个概念,前者用来存储数据,后者用来存储代码。JavaScript 中的函数相对于数据类型而言更加复杂,它可以有属性,也可以被赋值给一个变量,还可以作为参数被传递......正是这些强大特性让它成了 JavaScript 的“一等公民”。

下面我们就来详细了解函数的重要特性。

this 关键字

什么是 this?this 是 JavaScript 的一个关键字,一般指向调用它的对象。

这句话其实有两层意思,首先 this 指向的应该是一个对象,更具体地说是函数执行的“上下文对象”。其次这个对象指向的是“调用它”的对象,如果调用它的不是对象或对象不存在,则会指向全局对象(严格模式下 undefined)。

下面举几个例子来进行说明。

当代码 1 执行 fn() 函数时,实际上就是通过对象 o 来调用的,所以 this 指向对象 o。

- js

// 代码 1 var o = { fn() { console.log(this); }, }; o.fn(); // o 代码 2 也是同样的道理,通过实例 a 来调用,this 指向类实例 a。

- js

// 代码 2 class A { fn() { console.log(this); } } 代码 3 则可以看成是通过全局对象来调用,this 会指向全局对象(需要注意的是,严格模式下会是 undefined)。

- js

var a = new A(); a.fn(); // a // 代码 3 function fn() { console.log(this); } fn(); // 浏览器:Window;Node.js:global

是不是觉得 this 的用法很简单?别着急,我们再来看看其他例子以加深理解。

(1)如果在函数 fn2() 中调用函数 fn(),那么当调用函数 fn2() 的时候,函数 fn() 的 this 指向哪里呢?

function fn() {

console.log(this);

}

function fn2() {

fn();

}

fn2(); // ?由于没有找到调用 fn 的对象,所以 this 会指向全局对象,答案就是 window(Node.js 下是 global)。

(2)再把这段代码稍稍改变一下,让函数 fn2() 作为对象 obj 的属性,通过 obj 属性来调用 fn2,此时函数 fn() 的 this 指向哪里呢?

function fn() {

console.log(this);

}

function fn2() {

fn();

}

var obj = { fn2 };

obj.fn2(); // ?这里需要注意,调用函数 fn() 的是函数 fn2() 而不是 obj。虽然 fn2() 作为 obj 的属性调用,但 fn2()中的 this 指向并不会传递给函数 fn(), 所以答案也是 window(Node.js 下是 global)。

(3)对象 dx 拥有数组属性 arr,在属性 arr 的 forEach 回调函数中输出 this,指向的是什么呢?

var dx = {

arr: [1],

};

dx.arr.forEach(function () {

console.log(this);

}); // ?按照之前的说法,很多同学可能会觉得输出的应该是对象 dx 的属性 arr 数组。但其实仍然是全局对象。

如果你看过 forEach 的说明文档便会知道,它有两个参数,第一个是回调函数,第二个是 this 指向的对象,这里只传入了回调函数,第二个参数没有传入,默认为 undefined,所以正确答案应该是输出全局对象。

类似的,需要传入 this 指向的函数还有:every()、find()、findIndex()、map()、some(),在使用的时候需要特别注意。

(4)前面提到通过类实例来调用函数时,this 会指向实例。那么如果像下面的代码,创建一个 fun 变量来引用实例 b 的 fn() 函数,当调用 fun() 的时候 this 会指向什么呢?

class B {

fn() {

console.log(this);

}

}

var b = new B();

var fun = b.fn;

fun(); // ?这道题你可能会很容易回答出来:fun 是在全局下调用的,所以 this 应该指向的是全局对象。这个思路没有没问题,但是这里有个隐藏的知识点。那就是 ES6 下的 class 内部默认采用的是严格模式,实际上面代码的类定义部分可以理解为下面的形式。

class B {

"use strict";

fn() {

console.log(this);

}

}而严格模式下不会指定全局对象为默认调用对象,所以答案是 undefined。

(5)ES6 新加入的箭头函数不会创建自己的 this,它只会从自己的作用域链的上一层继承 this。可以简单地理解为箭头函数的 this 继承自上层的 this,但在全局环境下定义仍会指向全局对象。

var arrow = {

fn: () => {

console.log(this);

},

};

arrow.fn(); // ?所以虽然通过对象 arrow 来调用箭头函数 fn(),那么 this 指向不是 arrow 对象,而是全局对象。如果要让 fn() 箭头函数指向 arrow 对象,我们还需要再加一层函数,让箭头函数的上层 this 指向 arrow 对象。

var arrow = {

fn() {

const a = () => console.log(this);

a();

},

};

arrow.fn(); // arrow(6)前面提到 this 指向的要么是调用它的对象,要么是 undefined,那么如果将 this 指向一个基础类型的数据会发生什么呢?

比如下面的代码将 this 指向数字 0,打印出的 this 是什么呢?

[0].forEach(function () {

console.log(this);

}, 0); // ?结合上一讲关于数据类型的知识,我们知道基础类型也可以转换成对应的引用对象。所以这里 this 指向的是一个值为 0 的 Number 类型对象。

(7)改变 this 指向的常见 3 种方式有 bind、call 和 apply。call 和 apply 用法功能基本类似,都是通过传入 this 指向的对象以及参数来调用函数。区别在于传参方式,前者为逐个参数传递,后者将参数放入一个数组,以数组的形式传递。bind 有些特殊,它不但可以绑定 this 指向也可以绑定函数参数并返回一个新的函数,当 c 调用新的函数时,绑定之后的 this 或参数将无法再被改变。

function getName() {

console.log(this.name);

}

var b = getName.bind({ name: "bind" });

b();

getName.call({ name: "call" });

getName.apply({ name: "apply" });由于 this 指向的不确定性,所以很容易在调用时发生意想不到的情况。在编写代码时,应尽量避免使用 this,比如可以写成纯函数的形式,也可以通过参数来传递上下文对象。实在要使用 this 的话,可以考虑使用 bind 等方式将其绑定。

补充 1:箭头函数

箭头函数和普通函数相比,有以下几个区别,在开发中应特别注意:

不绑定 arguments 对象,也就是说在箭头函数内访问 arguments 对象会报错;

不能用作构造器,也就是说不能通过关键字 new 来创建实例;

默认不会创建 prototype 原型属性;

不能用作 Generator() 函数,不能使用 yeild 关键字。

函数的转换

在讲函数转化之前,先来看一道题:编写一个 add() 函数,支持对多个参数求和以及多次调用求和。示例如下:

add(1); // 1

add(1)(2); // 3

add(1, 2)(3, 4, 5)(6); // 21对于不定参数的求和处理比较简单,很容易想到通过 arguments 或者扩展符的方式获取数组形式的参数,然后通过 reduce 累加求和。但如果直接返回结果那么后面的调用肯定会报错,所以每次返回的必须是函数,才能保证可以连续调用。也就是说 add 返回值既是一个可调用的函数又是求和的数值结果。

要实现这个要求,我们必须知道函数相关的两个隐式转换函数 toString() 和 valueOf()。toString() 函数会在打印函数的时候调用,比如 console.log、valueOf 会在获取函数原始值时调用,比如加法操作。

具体代码实现如下,在 add() 函数内部定义一个 fn() 函数并返回。fn() 函数的主要职能就是拼接参数并返回自身,当调用 toString() 和 valueOf() 函数时对拼接好的参数进行累加求和并返回。

function add(...args) {

let arr = args;

function fn(...newArgs) {

arr = [...arr, ...newArgs];

return fn;

}

fn.toString = fn.valueOf = function () {

return arr.reduce((acc, cur) => acc + parseInt(cur));

};

return fn;

}原型

原型是 JavaScript 的重要特性之一,可以让对象从其他对象继承功能特性,所以 JavaScript 也被称为“基于原型的语言”。

严格地说,原型应该是对象的特性,但函数其实也是一种特殊的对象。例如,

我们对自定义的函数进行 instanceof Object 操作时,其结果是 true。

function fn() {}

fn instanceof Object; // true而且我们为了实现类的特性,更多的是在函数中使用它,所以在函数这一课时中来深入讲解原型。

什么是原型和原型链?

简单地理解,原型就是对象的属性,包括被称为隐式原型的 proto 属性和被称为显式原型的 prototype 属性。

隐式原型通常在创建实例的时候就会自动指向构造函数的显式原型。例如,在下面的示例代码中,当创建对象 a 时,a 的隐式原型会指向构造函数 Object() 的显式原型。

var a = {};

a.__proto__ === Object.prototype; // true

var b = new Object();

b.__proto__ === a.__proto__; // true显式原型是内置函数(比如 Date() 函数)的默认属性,在自定义函数时(箭头函数除外)也会默认生成,生成的显式原型对象只有一个属性 constructor ,该属性指向函数自身。通常配合 new 关键字一起使用,当通过 new 关键字创建函数实例时,会将实例的隐式原型指向构造函数的显式原型。

function fn() {}

fn.prototype.constructor === fn; // true看到这里,不少同学可能会产生一种错觉,那就是隐式原型必须和显式原型配合使用,这种想法是错误的。

下面的代码声明了 parent 和 child 两个对象,其中对象 child 定义了属性 name 和隐式原型 proto,隐式原型指向对象 parent,对象 parent 定义了 code 和 name 两个属性。

当打印 child.name 的时候会输出对象 child 的 name 属性值,当打印 child.code 时由于对象 child 没有属性 code,所以会找到原型对象 parent 的属性 code,将 parent.code 的值打印出来。同时可以通过打印结果看到,对象 parent 并没有显式原型属性。如果要区分对象 child 的属性是否继承自原型对象,可以通过 hasOwnProperty() 函数来判断。

var parent = { code: "p", name: "parent" };

var child = { __proto__: parent, name: "child" };

console.log(parent.prototype); // undefined

console.log(child.name); // "child"

console.log(child.code); // "p"

child.hasOwnProperty("name"); // true

child.hasOwnProperty("code"); // false在这个例子中,如果对象 parent 也没有属性 code,那么会继续在对象 parent 的原型对象中寻找属性 code,以此类推,逐个原型对象依次进行查找,直到找到属性 code 或原型对象没有指向时停止。

这种类似递归的链式查找机制被称作“原型链”。

new 操作符实现了什么?

前面提到显式原型对象在使用 new 关键字的时候会被自动创建。现在再来具体分析通过 new 关键字创建函数实例时到底发生了什么。

下面的代码通过 new 关键字创建了一个函数 F() 的实例。

function F(init) {}

var f = new F(args);其中主要包含了 3 个步骤:

创建一个临时的空对象,为了表述方便,我们命名为 fn,让对象 fn 的隐式原型指向函数 F 的显式原型;

执行函数 F(),将 this 指向对象 fn,并传入参数 args,得到执行结果 result;

判断上一步的执行结果 result,如果 result 为非空对象,则返回 result,否则返回 fn。

具体可以表述为下面的代码:

var fn = Object.create(F.prototype);

var obj = F.apply(fn, args);

var f = obj && typeof obj === "object" ? obj : fn;怎么通过原型链实现多层继承?

结合原型链和 new 操作符的相关知识,就可以实现多层继承特性了。下面通过一个简单的例子进行说明。

假设构造函数 B() 需要继承构造函数 A(),就可以通过将函数 B() 的显式原型指向一个函数 A() 的实例,然后再对 B 的显式原型进行扩展。那么通过函数 B() 创建的实例,既能访问用函数 B() 的属性 b,也能访问函数 A() 的属性 a,从而实现了多层继承。

function A() {}

A.prototype.a = function () {

return "a";

};

function B() {}

B.prototype = new A();

B.prototype.b = function () {

return "b";

};

var c = new B();

c.b(); // 'b'

c.a(); // 'a'补充 2:typeof 和 instanceof

typeof

用来获取一个值的类型,可能的结果有下面几种:

| 类型 | 结果 |

|---|---|

| Undefined | "undefined" |

| Boolean | "boolean" |

| Number | "number" |

| BigInt | "bigint" |

| String | "string" |

| Symbol | "symbol" |

| 函数对象 | "function" |

| 其他对象及 null | "object" |

instanceof

用于检测构造函数的 prototype 属性是否出现在某个实例对象的原型链上。例如,在表达式 left instanceof right 中,会沿着 left 的原型链查找,看看是否存在 right 的 prototype 对象。

left.__proto__.__proto__... =?= right.prototype作用域

作用域是指赋值、取值操作的执行范围,通过作用域机制可以有效地防止变量、函数的重复定义,以及控制它们的可访问性。

虽然在浏览器端和 Node.js 端作用域的处理有所不同,比如对于全局作用域,浏览器会自动将未主动声明的变量提升到全局作用域,而 Node.js 则需要显式的挂载到 global 对象上。又比如在 ES6 之前,浏览器不提供模块级别的作用域,而 Node.js 的 CommonJS 模块机制就提供了模块级别的作用域。但在类型上,可以分为全局作用域(window/global)、块级作用域(let、const、try/catch)、模块作用域(ES6 Module、CommonJS)及本课时重点讨论的函数作用域。

命名提升

对于使用 var 关键字声明的变量以及创建命名函数的时候,JavaScript 在解释执行的时候都会将其声明内容提升到作用域顶部,这种机制称为“命名提升”。

变量的命名提升允许我们在同(子)级作用域中,在变量声明之前进行引用,但要注意,得到的是未赋值的变量。而且仅限 var 关键字声明的变量,对于 let 和 const 在定义之前引用会报错。

console.log(a); // undefined

var a = 1;

console.log(b); // 报错

let b = 2;函数的命名提升则意味着可以在同级作用域或者子级作用域里,在函数定义之前进行调用。

fn(); // 2

function fn() {

return 2;

}结合以上两点我们再来看看下面两种函数定义的区别,方式 1 将函数赋值给变量 f;方式 2 定义了一个函数 f()。

// 方式1

var f = function() {...}

// 方式2

function f() {...}两种方式对于调用函数方式以及返回结果而言是没有区别的,但根据命名提升的规则,我们可以得知方式 1 创建了一个匿名函数,让变量 f 指向它,这里会发生变量的命名提升;如果我们在定义函数之前调用会报错,而方式 2 则不会。

闭包

在函数内部访问外部函数作用域时就会产生闭包。闭包很有用,因为它允许将函数与其所操作的某些数据(环境)关联起来。这种关联不只是跨作用域引用,也可以实现数据与函数的隔离。

比如下面的代码就通过闭包来实现单例模式。

var SingleStudent = (function () {

function Student() {}

var _student;

return function () {

if (_student) return _student;

_student = new Student();

return _student;

};

})();

var s = new SingleStudent();

var s2 = new SingleStudent();

s === s2; // true函数 SingleStudent 内部通过闭包创建了一个私有变量 _student,这个变量只能通过返回的匿名函数来访问,匿名函数在返回变量时对其进行判断,如果存在则直接返回,不存在则在创建保存后返回。

补充 3:经典笔试题

for (var i = 0; i < 5; i++) {

setTimeout(() => {

console.log(i);

}, 1000 * i);

}这是一道作用域相关的经典笔试题,需要实现的功能是每隔 1 秒控制台打印数字 0 到 4。但实际执行效果是每隔一秒打印的数字都是 5,为什么会这样呢?

如果把这段代码转换一下,手动对变量 i 进行命名提升,你就会发现 for 循环和打印函数共享了同一个变量 i,这就是问题所在。

var i;

for (i = 0; i < 5; i++) {

setTimeout(() => {

console.log(i);

}, 1000 * i);

}要修复这段代码方法也有很多,比如将 var 关键字替换成 let,从而创建块级作用域。

for (let i = 0; i < 5; i++) {

setTimeout(() => {

console.log(i);

}, 1000 * i);

}

/**

等价于

for(var i = 0; i < 5; i++ ) {

let _i = i

setTimeout(() => {

console.log(_i);

}, 1000 * i)

}

*/函数总结

本课时介绍了函数相关的重要内容,包括 this 关键字的指向、原型与原型链的使用、函数的隐式转换、函数和作用域的关系,希望大家能理解并记忆。

最后布置一道思考题:结合本课时的内容,思考一下修改函数的 this 指向,到底有多少种方式呢?

答:绑定 this,有 bind,apply,call。还有箭头函数

如何复用代码(模块化)

作为前端工程师的你,或许早已习惯了在编写浏览器组件时使用 import 和 from 来管理代码模块,在编写 Node.js 服务时通过 require 和 module.exports 来复用代码。但 JavaScript 模块化之路充满了坎坷。这一课时就带你由近及远,看看 JavaScript 模块发展史上那些著名的模块规范与实现。

ES6 模块

目前最主流的模块化方案应该是 ECMAScript 2015 提出的模块化规范(也称“ES6 模块”),这个规范同时适用于 JavaScript 的前后端环境。

定义和引用

由于目前大多数项目都使用了 ES6 模块规范,大家对用法应该比较熟悉,这里就不多介绍了,只补充 3 个小知识:

ES6 模块强制自动采用严格模式,所以说不管有没有“user strict”声明都是一样的,换言之,编写代码的时候不必再刻意声明了;

虽然大部分主流浏览器支持 ES6 模块,但是和引入普通 JS 的方式略有不同,需要在对应 script 标签中将属性 type 值设置为“module”才能被正确地解析为 ES6 模块;

在 Node.js 下使用 ES6 模块则需要将文件名后缀改为“.mjs”,用来和 Node.js 默认使用的 CommonJS 规范模块作区分。

特性

ES6 模块有两个重要特性一定要掌握,一个是值引用,另一个是静态声明。

值引用是指 export 语句输出的接口,与其对应的值是动态绑定关系。即通过该接口,可以取到模块内部实时的值,可以简单地理解为变量浅拷贝。

下面是一个简单的例子,模块 a 导出变量 a,初始值为空字符串,500 毫秒后赋值为字符串 'a';模块 b 引用模块 a 并打印,控制台输出空字符串,1 秒后继续打印,控制台输出字符串 'a'。

// a.js

export var a = "";

setTimeout(() => (a = "a"), 500);

// b.js

import { a } from "./a.js";

console.log(a); // ''

setTimeout(() => console.log(a), 1000); // 'a'ES6 模块对于引用声明有严格的要求,首先必须在文件的首部,不允许使用变量或表达式,不允许被嵌入到其他语句中。所以下面 3 种引用模块方式都会报错。

// 必须首部声明

let a = 1

import { app } from './app';

// 不允许使用变量或表达式

import { 'a' + 'p' + 'p' } from './app';

// 不允许被嵌入语句逻辑

if (moduleName === 'app') {

import { init } from './app';

} else {

import { init } from './bpp';

}定义这些严格的要求可不仅仅是为了代码的可读性,更重要的是可以对代码进行静态分析。

静态分析是指不需要执行代码,只从字面量上对代码进行分析。例如,在上面的错误代码中,有一段代码需要通过判断变量 moduleName 的值来加载对应的模块,这就意味着需要执行代码之后才能判断加载哪个模块,而 ES6 模块则不需要。这样做的好处是方便优化代码体积,比如通过 Tree-shaking 操作消除模块中没有被引用或者执行结果不会被用到的无用代码。

延伸 1:import 的动态模块提案

虽然 ES6 模块设计在 90% 情况下是很有用的,特别是配合一些工具使用,但是却无法应付某些特殊场景。比如,出于性能原因对代码进行动态加载,所以在 ES2020 规范提案中,希望通过 import():tc39/proposal-dynamic-import: import() proposal for JavaScript (github.com))函数来支持动态引入模块。

具体用法如下所示,调用 import() 函数传入模块路径,得到一个 Promise 对象。

import(`./section-modules/${link.dataset.entryModule}.js`)

.then((module) => {

module.loadPageInto(main);

})

.catch((err) => {

main.textContent = err.message;

});import() 函数违反了上面静态声明的所有要求,并且提供了其他更强大的功能特性。

违反首部声明要求,那么就意味着可以在代码运行时按需加载模块,这个特性就可以用于首屏优化,根据路由和组件只加载依赖的模块。

违反变量或表达式要求,则意味着可以根据参数动态加载模块。

违反嵌入语句逻辑规则,可想象空间更大,比如可以通过 Promise.race 方式同时加载多个模块,选择加载速度最优模块来使用,从而提升性能。

CommonJS

CommonJS 最初名为 Server.js,是为浏览器之外的 JavaScript 运行环境提供的模块规范,最终被 Node.js 采用。

CommonJS 定义和引用

CommonJS 规定每个文件就是一个模块,有独立的作用域。每个模块内部,都有一个 module 对象,代表当前模块。通过它来导出 API,它有以下属性:

id 模块的识别符,通常是带有绝对路径的模块文件名;

filename 模块的文件名,带有绝对路径;

loaded 返回一个布尔值,表示模块是否已经完成加载;

parent 返回一个对象,表示调用该模块的模块;

children 返回一个数组,表示该模块要用到的其他模块;

exports 表示模块对外输出的值。

引用模块则需要通过 require 函数,它的基本功能是,读入并执行一个 JavaScript 文件,然后返回该模块的 exports 对象。

CommonJS 特性

CommonJS 特性和 ES6 恰恰相反,它采用的是值拷贝和动态声明。值拷贝和值引用相反,一旦输出一个值,模块内部的变化就影响不到这个值了,可以简单地理解为变量浅拷贝。

仍然使用上面的例子,改写成 CommonJS 模块,在 Node.js 端运行,控制台会打印两个空字符串。

// a.js

var a = "";

setTimeout(() => (a = "a"), 500);

module.exports = a;

// b.js

var a = require("./a.js");

console.log(a); // ''

setTimeout(() => console.log(a), 1000); // ''动态声明就很好理解了,就是消除了静态声明的限制,可以“自由”地在表达式语句中引用模块。

AMD

在 ES6 模块出现之前,AMD(Asynchronous Module Definition,异步模块定义)是一种很热门的浏览器模块化方案。

AMD 定义和引用

AMD 规范只定义了一个全局函数 define,通过它就可以定义和引用模块,它有 3 个参数:

define(id?, dependencies?, factory);第 1 个参数 id 为模块的名称,该参数是可选的。如果没有提供该参数,模块的名字应该默认为模块加载器请求的指定脚本的名字;如果提供了该参数,模块名必须是“顶级”的和绝对的(不允许相对名字)。

第 2 个参数 dependencies 是个数组,它定义了所依赖的模块。依赖模块必须根据模块的工厂函数优先级执行,并且执行的结果应该按照依赖数组中的位置顺序以参数的形式传入(定义中模块的)工厂函数中。

第 3 个参数 factory 为模块初始化要执行的函数或对象。如果是函数,那么该函数是单例模式,只会被执行一次;如果是对象,此对象应该为模块的输出值。

下面是一个简单的例子,创建一个名为“alpha”的模块,依赖了 require、exports、beta 3 个模块,并导出了 verb 函数。

define("alpha", ["require", "exports", "beta"], function (

require,

exports,

beta

) {

exports.verb = function () {

return beta.verb();

};

});AMD 特性

它的重要特性就是异步加载。所谓异步加载,就是指同时并发加载所依赖的模块,当所有依赖模块都加载完成之后,再执行当前模块的回调函数。这种加载方式和浏览器环境的性能需求刚好吻合。

由于 AMD 并不是浏览器原生支持的模块规范,所以需要借助第三方库来实现,其中最有名的就是 RequireJS。它的核心是两个全局函数 define 和 require,define 函数可以将依赖注入队列中,并将回调函数定义成模块;

require 函数主要作用是创建 script 标签请求对应的模块,然后加载和执行模块。下面是部分源码,有兴趣的同学可以看完整的源码。

var requirejs, require, define;

(function (global, setTimeout) {

...

define = function (name, deps, callback) {

...

if (context) {

context.defQueue.push([name, deps, callback]);

context.defQueueMap[name] = true;

} else {

globalDefQueue.push([name, deps, callback]);

}

};

...

req.load = function (context, moduleName, url) {

...

if (isBrowser) {

node = req.createNode(config, moduleName, url);

...

if (baseElement) {

head.insertBefore(node, baseElement)

} else {

head.appendChild(node)

}

currentlyAddingScript = null;

return node

}

};

...

}(this, (typeof setTimeout === 'undefined' ? undefined : setTimeout)));CMD

CMD(Common Module Definition,通用模块定义)是基于浏览器环境制定的模块规范。

CMD 定义和引用

CMD 定义模块也是通过一个全局函数 define 来实现的,但只有一个参数,该参数既可以是函数也可以是对象: define(factory);

如果这个参数是对象,那么模块导出的就是对象;如果这个参数为函数,那么这个函数会被传入 3 个参数 require 、 exports 和 module。

define(function (require, exports, module) {

//...

});第 1 个参数 require 是一个函数,通过调用它可以引用其他模块,也可以调用 require.async 函数来异步调用模块。

第 2 个参数 exports 是一个对象,当定义模块的时候,需要通过向参数 exports 添加属性来导出模块 API。

第 3 个参数 module 是一个对象,它包含 3 个属性:

uri,模块完整的 URI 路径;

dependencies,模块的依赖;

exports,模块需要被导出的 API,作用同第二个参数 exports。

下面是一个简单的例子,定义了一个名为 increment 的模块,引用了 math 模块的 add 函数,经过封装后导出成 increment 函数。

define(function (require, exports, module) {

var add = require("math").add;

exports.increment = function (val) {

return add(val, 1);

};

module.id = "increment";

});CMD 特性

CMD 最大的特点就是懒加载,和上面示例代码一样,不需要在定义模块的时候声明依赖,可以在模块执行时动态加载依赖。当然还有一点不同,那就是 CMD 同时支持同步加载模块和异步加载模块。

用一句话来形容就是,它整合了 CommonJS 和 AMD 规范的特点。遵循 CMD 规范的代表开源项目是 sea.js ,它的实现和 requirejs 没有本质差别,有兴趣的同学可以看其源码:seajs/seajs: A Module Loader for the Web (github.com)。

UMD

UMD(Universal Module Definition,统一模块定义)其实并不是模块管理规范,而是带有前后端同构思想的模块封装工具。通过 UMD 可以在合适的环境选择对应的模块规范。比如在 Node.js 环境中采用 CommonJS 模块管理,在浏览器端且支持 AMD 的情况下采用 AMD 模块,否则导出为全局函数。 它的实现原理也比较简单:

先判断是否支持 Node.js 模块格式(exports 是否存在),存在则使用 Node.js 模块格式;

再判断是否支持 AMD(define 是否存在),存在则使用 AMD 方式加载模块;

若前两个都不存在,则将模块公开到全局(Window 或 Global)。

大致实现如下:

(function (root, factory) {

if (typeof define === "function" && define.amd) {

define([], factory);

} else if (typeof exports === "object") {

module.exports, (module.exports = factory());

} else {

root.returnExports = factory();

}

})(this, function () {

//。。。

return {};

});延伸 2:ES5 标准下如何编写模块

模块的核心就是创建独立的作用域,要实现这个目的,我们在第 08 课时中提到过,可以通过函数来实现。 如果直接在全局作用域下定义函数会很容易因为命名冲突而导致代码覆盖,为了避免这种情况可以通过对象创建“命名空间”。但是它有个缺点,就是无法创建私有变量,并不符合“高内聚、低耦合”的编码原则,也容易出现 bug。

var mod = {

a: '',

f: function() {

...

},

}为了解决这个问题,立即执行函数的形式也就出现了,这种形式就是在定义函数的时候就调用它并导出模块 API。

var mod = (function(w){

function f() {

...

}

var a = ''

...

return {

f,

a

};

})(window);有了这两个基础知识点,我们再通过 webpack 编译 ES6 模块的例子加深理解。

下面的代码定义了 2 个 ES6 模块,分别是 index.js、m.js,其中模块 index.js 依赖 m.js 模块的 API:

// index.js

import { text, write } from "./m";

write(`<h1>${text} ${text2}</h1>`);

// m.js

const write = (content) => document.write(content);

var text = "hello";

export { text, write };查看编译后的代码我们发现,整个代码就是一个立即执行函数,这个立即执行函数的参数就是对象形式的模块定义。

// bundle.js

(function(modules) {

...

})({

"./index.js": (function(module, __webpack_exports__, __webpack_require__) {

...

},

"./m.js": (function(module, __webpack_exports__, __webpack_require__) {

...

}

})这个立即执行函数会加载一个初始模块,也就是 webpack 配置的 entry 模块,按照依赖关系调用模块对应的函数并缓存。

function (modules) {

var installedModules = {};

function __webpack_require__(moduleId) {

if (installedModules[moduleId]) {

return installedModules[moduleId].exports;

}

var module = installedModules[moduleId] = {

i: moduleId,

l: false,

exports: {}

};

modules[moduleId].call(module.exports, module, module.exports, __webpack_require__);

module.l = true;

return module.exports;

}

...

return __webpack_require__(__webpack_require__.s = "./index.js");

}那么这些 ES6 模块是怎么转化成函数的呢?

从上面的代码我们可以看到,每个模块定义函数都会传入 3 个参数,其中参数 module 可以理解为当前模块的配置参数,包含模块 id 等信息。参数 webpack_exports 是一个对象,模块需要导出的 API 都可以添加到这个对象上;参数 webpack_require 是一个函数,负责引用依赖的模块。

// index.js 中引入 m.js 模块

var _m__WEBPACK_IMPORTED_MODULE_0__ = __webpack_require__(/*! ./m */ "./m.js");

// m.js 中导出字符串 text 和函数 write

__webpack_require__.d(__webpack_exports__, "text", function () {

return text;

});

__webpack_require__.d(__webpack_exports__, "write", function () {

return write;

});

const write = (content) => document.write(content);

var text = "hello";这就是通过对象和立即执行函数来实现代码模块化的基本方法,对实现细节有兴趣的同学可以找一段编译后的代码进行研究。

模块化复用代码总结

本课时主要介绍了 JavaScript 模块化规范,包括原生规范 ES6 模块、Node.js 采用的 CommonJS,以及开源社区早期为浏览器提供的规范 AMD,具有 CommonJS 特性和 AMD 特性的 CMD,让 CommonJS 和 AMD 模块跨端运行的 UMD。希望你对模块系统有更全面地认识,从而加深对 JavaScript 的理解。

最后留一道思考题:如果要实现一个支持动态加载的 import() 函数,该怎么做呢?

答:

- 首先实现一个配置表,当需要某个 JS 时 去匹配配置表,然后用 JSONP 请求过来,eveal 执行

- 使用 Promise 来实现 动态加载的 import()

为什么 JavaScript 不适合大型项目(typescript 的兴起)

随着前端快速发展,JavaScript 语言的设计缺陷在大型项目中逐渐显露。

复用代码的模块问题就是其中之一,但庆幸的是,ES6 模块在原生层面解决了这个问题,不同环境下的兼容性问题也可以由工具转化代码来解决。

这一课时要提到的类型问题,是一个需要依赖第三方规范和工具来解决的缺陷。JavaScript 的类型问题具体表现在下面 3 个方面。

类型声明:

前面在第 08 课时中已经提过命名的提升特性,如果某个变量命名提升到全局,那么将是危险的。比如下面的代码,函数 fn 内部使用了一个变量 c,由于忘记使用关键字来声明,结果导致覆盖了全局变量 c。

var c = 0

...

function fn() {

...

c = 30;

}

fn();动态类型:

动态类型是指在运行期间才做数据类型检查的语言,即动态类型语言编程时,不用给任何变量指定数据类型。

下面是一个简单的例子,定义了一个函数 printId 来返回某个对象的 id 属性。如果我们在调用函数 printId 时要想了解参数 user 的数据结构和返回值类型,只能通过查看源码,或者运行时调试、打印来获取。当函数结构复杂,参数较多时这个过程就会大大降低代码的可维护性。虽然添加注释能在一定程度上缓解问题,但为函数编写注释并不是强制性约束,能否及时同步注释也可能会成为新的问题。

就函数 printId 本身而言,也无法在编译时校验参数的合法性,只能在运行时添加校验逻辑,这也大大增加了程序出现 bug 的概率。

function printId(user) {

return user.id;

}弱类型:

弱类型是指一个变量可以被赋予不同数据类型的值。这也是一个既灵活又可怕的特性,编写代码的时候非常方便,不用考虑变量的数据类型,但这也很容易出现 bug,调试起来会变得相当困难。

var tmp = []

...

tmp = null

...

// tmp 到底会变成什么?为了解决上面 3 个问题,开源社区提供了解决方案——TypeScript。它是基于 JavaScript 的语法糖,也就是说 TypeScript 代码没有单独的运行环境,需要编译成 JavaScript 代码之后才能运行。

从它的名字不难看出,它的核心特性是类型“Type”。具体工作原理就是在代码编译阶段进行类型检测,这样就能在代码部署运行之前及时发现问题。

类型与接口

TypeScript 让 JavaScript 变成了静态强类型、变量需要严格声明的语言,为此定义了两个重要概念:类型(type)和接口(interface)。

TypeScript 在 JavaScript 原生类型的基础上进行了扩展,但为了和基础类型对象进行区分,采用了小写的形式,比如 Number 类型对应的是 number。类型之间可以互相组合形成新的类型。

一些数据类型在前面第 07 课时中已经提过,这里不再赘述。下面补充一下 TypeScript 扩展的类型。

元组

元组可以看成是具有固定长度的数组,其中数组元素类型可以不同。比如下面的代码声明了一个元组变量 x,x 的第一个元素是字符串,第二个是数字;又比如 react hooks 就是用到了元组类型。

let x: [string, number];枚举

枚举指的是带有名字的常量,可以分为数字枚举、字符串枚举和异构枚举(字符串和数字的混合)3 种。比较适用于前后端通用的枚举值,比如通过 AJAX 请求获取的数据状态,对于仅在前端使用的枚举值还是推荐使 Symbol。

下面是一个异构枚举的例子,定义了数字枚举值 0 和字符串枚举值 "YES"。

enum example {

No = 0,

Yes = "YES",

}也可以使用 const 修饰符来定义枚举值,通过这种定义方式,TypeScript 会在编译的时候,直接把枚举引用替换成对应的枚举值而非创建枚举对象。

enum example {

No = 0,

Yes = "YES",

}

console.log(example.No)

// 编译成

var example;

(function (example) {

example[example["No"] = 0] = "No";

example["Yes"] = "YES";

})(example || (example = {}));

console.log(example.No);

////////////

const enum example {

No = 0,

Yes = "YES",

}

console.log(example.No)

// 编译成

console.log(0 /* No */);any

any 类型代表可以是任何一种类型,所以会跳过类型检查,相当于让变量或返回值又变成弱类型。因此建议尽量减少 any 类型的使用。

void

void 表示没有任何类型,常用于描述无返回值的函数。

never

never 类型表示的是那些永不存在的值的类型,对于一些特殊的校验场景比较有用,比如代码的完整性检查。下面的示例代码通过穷举判断变量 u 的值来执行对应逻辑,如果此时变量 u 的可选值新增了字符串 "c",那么这段代码并不会给出提示告诉开发者还有一种 u 等于字符串 "c" 的场景,但如果增加 never 类型赋值的话在编译时就可以给出提示。

let u: "a" | "b";

//...

if (u === "a") {

//...

} else if (u === "b") {

//...

}增加了 never 类型变量赋值:

let u: "a" | "b" | "c";

//...

if (u === "a") {

//...

} else if (u === "b") {

//...

} else {

let trmp: never = u; // Type '"c"' is not assignable to type 'never'.

}接口的作用和类型非常相似,在大多数情况下可以通用,只存在一些细小的区别(比如同名接口可以自动合并,而类型不能;在编译器中将鼠标悬停在接口上显示的是接口名称,悬停在类型上显示的是字面量类型),最明显的区别还是在写法上。

/* 声明 */